Texto em que o autor apresenta e defende suas ideias e opiniões, a partir da interpretação de fatos e dados.

Precisamos nos preparar para conviver com a IA que ameaça nossa existência?

Como entender o grande ponto de interrogação da tecnologia, que é o do surgimento da inteligência artificial geral? Aquela que, nas palavras do futurista Nick Bostrom (Oxford), nos ameaçaria existencialmente, por sua capacidade de nos substituir e mesmo subjugar. Para responder, gostaria que você primeiramente considerasse uma alegoria sobre conhecimento adquirido, conhecimento estendido e o universo das coisas ignoradas.

Considere um comboio interminável de carros seguindo por uma avenida tediosa. De repente, o farol fecha e um segundo comboio entra em cena, sob a sinaleira do cruzamento.

Pedestre que é, você espera pacientemente na esquina e divaga: tudo o que sei, todo o conhecimento que jamais adquiri, está neste quarteirão que os carros desenham.

Para tocar o conhecimento, basta abrir a porta do passageiro e pisar o chão. Já para cair no solo do que é radicalmente ignorado, é só abrir a porta do motorista e pular no desconhecido.

Mas, quarteirões são tão pequenos, lamenta. Melhor não pensar assim. Do outro lado da rua, alguém tasca o dedo naquele botão que parece ter sido inventado para iludir os pedestres sobre a sua importância no trânsito.

O tempo extra de espera serve de gatilho para uma segunda visão do assunto: as avenidas que vejo daqui definem mais do que um quarteirão; elas dão contorno ao próprio bairro, onde casas, burburinhos e pessoas personificam o conhecimento que pode ser atingido a partir das bases possuídas —aquele que para se ter acesso basta querer e viver.

A diferença entre os quarteirões (conhecimento adquirido) e os bairros (a área do conhecimento estendido) não pode ser menosprezada. Ela importa para os passageiros dos carros, que veem crescer o número de paradas na calçada do conhecimento, e importa para os motoristas, que encontram mais oportunidades para caírem no terreno do que ignoram por completo, o único que veem crescer pela janela, enquanto rodam pela metrópole interminável.

Então, afinal, parece mesmo que a expansão da área do conhecimento leva ao aumento da ignorância, já que esta é intrínseca ao perímetro percorrido por quem gosta de andar sobre fronteiras —é o que pensa, antes de abandonar o assunto, aparentemente pacificado.

Não é bem assim

O problema de se ter ideias no corre-corre do dia é a tendência para tratá-las como suficientes ou definitivas. Ideia boa é ideia revisitada. São aquelas que ressurgem em novas engenharias de palavras, dando provas e mais provas da sua inevitabilidade.

Epifania ou "insight" é apenas um truque psicológico, que por razões energéticas, nos leva a ficar satisfeitos com a primeira coisa que nos vêm à mente. Sempre é bom lembrar que existem cidades de poucos bairros, com bairros de poucos quarteirões.

Conforme o carro cruza pela avenida central de uma dessas cidades pequenininhas, e o passageiro vê crescer a área do conhecimento, percebe que a área da ignorância diminui. Aliás, ela diminui tão rapidamente que bastam umas duas ou três voltas para não sobrar praticamente mais nada.

No fundo, essa parece ser a regra. Cada metrinho a mais percorrido representa uma área menor a ser descoberta. O motorista, coitado, parece iludido. Conhecer reduz sim o terreno daquilo que ignoramos por completo, pessoalmente e como cultura. Defender o oposto, na prática, não faz sentido. Certo?

Depende. E se carros e avenidas não forem apenas o que as pessoas imaginam? E se a fronteira cortar todo o universo, esta metrópole interminável?

Olhando da escotilha de sua nave, o cosmonauta teria uma visão diferente de quem circula pelas cidades pequenas: do seu ponto de vista, não importa o tamanho da área ocupada pelo conhecimento, adquirido e estendido, quando a sua fronteira se estende muito além daquilo que podemos prever e mesmo do desaparecimento da espécie humana.

Quem está certo? Aquele que vê da cidade ou o que vê do espaço sideral? Os dois e nenhum, é claro.

Considere, por um momento, que ao invés de conhecimento em sentido abstrato estejamos falando sobre macetes técnicos. Mesmo que em teoria eles sejam incontáveis, depois de algum tempo, a sensação é de que chegamos lá.

Não há muito mais a se aprender sobre o jogo de damas e sobre a física que rege a trajetória dos foguetes. A maior parte dos assuntos cotidianos são assim e, portanto, vão se resolvendo. Ainda mais profundamente, tem gente que prefere ver as coisas por este ângulo.

Agora, consideremos aquilo que se pode saber sobre as manifestações da criatividade e a estrutura do universo, anterior ao Big Bang. Como falar em esgotamento da ignorância, quando as categorias a serem criadas sequer podem ser concebidas, a partir daquilo que sabemos hoje em dia? Mais do que truísmo, eis um segundo ângulo.

A ideia de uma inteligência artificial geral vem dividindo especialistas e mobilizando comentadores ao redor do mundo. No meu ponto de vista, ela trafega por esta alegoria.

Paradoxo do conhecimento dá norte para a evolução da IA

A questão mais quente sobre a evolução da tecnologia é se/quando a inteligência artificial —ou "inteligência de máquina" para ser mais preciso— irá ombrear a humana. Este ponto marcaria o surgimento da chamada IA Forte, em oposição às aplicações mais específicas que existem hoje em dia, conhecidas como Restritas.

Entre os Labs investindo pesado no assunto estão Deepmind (Google), Google Brain, Open AI (Microsoft, Elon Musk), Facebook AI e diversos laboratórios acadêmicos ao redor do mundo.

Pesquisa da consultoria Mind Commerce sugere que os investimentos em IA Forte chegarão a US$ 50 bi em 2023.

A escalada das apostas vem sendo acompanhada por discursos inflamados sobre os riscos existenciais que esta nova fase da inteligência não biológica trará. De Nick Bostrom (Oxford) a Elon Musk, a ordem é se preparar enquanto é tempo.

Curiosamente, esta não é a visão de Yoshua Benggio e Yann LeCun, ganhadores da Medalha Turing (Nobel da computação) pela criação do Deep Learning, paradigma central da inteligência artificial. Na visão de ambos, nem a tecnologia atual, nem o conhecimento que possuímos sobre o funcionamento do cérebro dão pistas da IA Forte.

IA Forte não existe pois não existe essa história de inteligência geral. Nós podemos falar em inteligência de rato, inteligência de gato, inteligência de cachorro e inteligência de humanos, mas não de inteligência artificial geral"

Eu estou bem mais com Benggio e LuCun do que com Bostrom e Musk, mas entendo que os bilhões investidos pelo Google, Microsoft e outras estão longe de serem mera queima de caixa.

O caso aqui é que, se por IA Forte queremos dizer simulação, a história é uma; se aquilo que temos em mente é duplicação, então é outra. É neste sentido que a alegoria inicial se aplica. Não se trata apenas de uma discussão sobre aquilo que a tecnologia pode atingir, mas também do que se espera dela.

Em outubro de 1950, Alan Turing publicou o artigo N1 da ciência da computação até hoje, no qual descreveu o famoso teste que serviria para chancelar o caráter inteligente de um programa.

Segundo ele, esta chancela deveria ser dada pela capacidade do programa se passar por uma pessoa por cinco minutos, de acordo com uma parte de seus interlocutores (30%). Quer dizer, não importa que raios acontece dentro da máquina; tudo o que precisamos observar é a qualidade dos seus outputs.

Influenciado por uma linha do pensamento dominante na segunda metade do século 20, conhecida como behaviorismo, Turing fincou a bandeira mais alta da tecnologia no topo da colina da simulação.

Em 2014, um programa de computador chamado Eugene Goostman fez certo barulho na mídia, ao passar o teste de Turing, de acordo com um painel de jurados da Universidade de Reading. O programa simulava um menino ucraniano de 13 anos de idade. Outros vieram a seguir, enquanto o impacto no mundo real foi próximo de zero.

Ano passado, as coisas começaram a mudar, com o lançamento do GPT-3, que adota um tipo de algoritmo conhecido como Transformer, treinado em montanhas de dados. Até o The Guardian publicou uma reportagem escrita pelo software (com trechos selecionados pelos editores, conforme explicado aqui).

O passo foi grande, mas, como sempre é o caso, o entusiasmo inicial foi seguido por experimentos que deixam claro o quanto a simulação que ele faz é cheia de buracos. Tanto é assim que, hoje em dia, uma das principais sugestões do auto-complete do Google em inglês para GPT-3 é is a HOAX (é um caô), o que está longe de ser verdade.

Eu não tenho dúvida que seus sucessores irão tapar boa parte destes buracos; aliás, é isto o que parece que já foi feito pelo Wu Dao 2.0, primo chinês do GPT-3, que possui dez vezes mais parâmetros do que este e que estou tentando acessar desde o mês passado (para um benchmark dos sistemas de inteligência artificial mais recentes, incluindo o Wu Dao 2.0, veja aqui). Assim iremos avançar de simulação em simulação, cobrindo boa parte do que as pessoas falam e fazem.

Estas simulações irão cobrir áreas e mais áreas com relativa velocidade, tendo como marcos principais:

- Capacidade de entender intenções explícitas no comportamento e expressões;

- Capacidade de fazer analogias e;

- Comportamento preventivo ou antecipatório.

Se é isto que você espera da inteligência artificial geral, então, pode apostar que ela chegará em breve (30-40 anos).

Uma coisa radicalmente distinta desta linha evolutiva é a da duplicação da inteligência biológica, especialmente a humana.

Um exemplo simples ajuda a entender o xis da questão. Imagine que você estava lendo este artigo e, em função de determinada colocação, lembrou de um amigo e decidiu copiar imediatamente o link da publicação e mandar por WhatsApp. Porém, na hora de mandar, você pensou melhor e acho que mais valia a pena terminar de ler antes de o fazer.

Esta dinâmica trivial pressupõe que você criou uma representação mental, a qual levou a uma relação lateral com uma projeção dos interesses de outra pessoa (eventualmente, em função de zonas de convergências entre vocês, tacitamente identificadas).

A associação foi suficientemente forte para motivar a ruptura com o comportamento corrente (leitura) e iniciar uma dinâmica comportamental alternativa (mandar o link), ao passo que um impulso motivacional de direção contrária entrou em ação, recolocando você na trilha original do comportamento.

A questão com isso tudo não é que estas coisas que acontecem num piscar de olhos são complexas ou coisa do gênero. A questão é que elas só podem acontecer porque existe um ambiente geral de interconexão entre as experiências de tempo presente, os fragmentos de memória e as prioridades, apoiadas em afetos e tudo o mais que temos acesso dentro do nosso corpo e no mundo.

Muita gente diz que o xis da questão é a consciência humana. Eu não acho que precisemos colocar as coisas nestes termos —pelo menos, não a priori. O ponto crítico é sobre direcionamentos intencionais.

Algo prende sua atenção porque faz conexão com propósitos prévios. No exemplo acima, estes parecem ligados à individualidade. Então, um novo propósito ou direcionamento entra em cena, este mais ligado às relações interpessoais. Finalmente, intervém uma espécie de propósito organizador, que hierarquiza prioridades, definindo: primeiro finalizar a leitura, depois compartilhar o artigo.

O propósito organizador é a evidência mais forte de uma forma de interação com a vida interior e a realidade exterior que envolve crenças sobre o que é mais importante, à luz da forma como nós e os outros irão se sentir, dadas as diferentes possibilidades de ação.

É, acima de tudo, uma manifestação do que se entende por modelos vivenciais atravessados por linhas de força intencionais, as quais organizamos em função de nossas crenças e aspirações, assim como traumas e outras linhas de força que preferiríamos evitar.

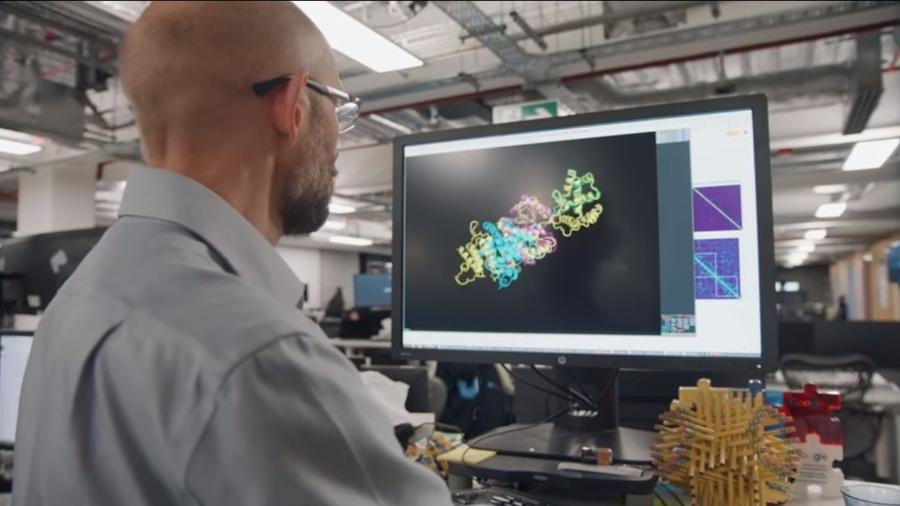

Já o GPT-3 faz a sua mágica convertendo solicitações feitas pelos usuários em matrizes numéricas, que servem de base para processamentos estatísticos, que estimam a resposta mais adequada.

As estimativas são feitas por meio de uma espécie de rede neural, com 96 camadas (algoritmos Transformers, como mencionei anteriormente), cada uma delas com cerca de 1,8 bilhão de parâmetros cada, ao passo que a matriz em si conta com cerca de 175 bilhões de números.

A diferença entre ambos os procedimentos é grande o suficiente para podermos dizer que quanto mais entendemos como funciona a inteligência artificial de hoje, mais facilmente podemos reconhecer as áreas em que somos radicalmente ignorantes, no que se refere a tudo aquilo que requer um futuro criado pelos roteiristas de Black Mirror. E que quem tem este modelo de inteligência artificial em mente pode desistir de esperar.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.