Seis questões sobre o anúncio da Meta e o seu impacto no Brasil

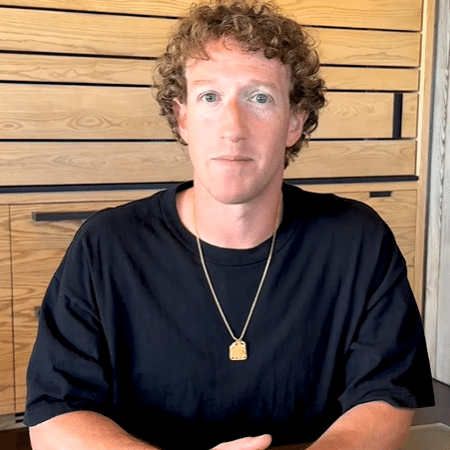

O vídeo de Mark Zuckerberg anunciando novas regras sobre moderação de conteúdo nas plataformas da Meta é o abre-alas de 2025 que ninguém pediu, mas que imediatamente chacoalha o mundo dentro e fora das telas. Vestindo uma roupa descolada e com o ar bastante informal, o CEO da Meta anunciou o encerramento do programa de checagem de fatos, a derrubada de filtros sobre temas como imigração e gênero na plataforma, o foco da moderação automatizada apenas para ofensas graves, além da volta de publicações políticas em destaque nas redes da empresa.

Muito se falou sobre como esse anúncio representa um alinhamento com a visão de mundo do segundo governo Trump nos Estados Unidos, e como a Meta assim segue os passos dados por Elon Musk na governança de plataformas digitais.

São tantas as repercussões e análises que podem ser feitas sobre essa guinada da empresa, que resolvemos dedicar essa coluna aos temas que podem ter passado debaixo do radar nos últimos dias e sobre os quais gostaríamos de chamar a sua atenção. Considere esta a nossa coluna sobre previsões para 2025, já que muitos desses temas vão acabar ocupando o noticiário sobre tecnologia e política ao longo do ano.

1. Supremo e Meta nem tão diferentes assim

Um foco da cobertura sobre o anúncio de Zuckerberg foi a menção pelo CEO da Meta a "cortes secretas na América Latina" que emitiriam ordens sobre remoção de conteúdo. A referência parece mirar no papel do STF, que no curso das investigações que levaram à derrubada do X, por exemplo, emitiu decisões ordenando a remoção de conteúdos que expunham dados de delegado e de autoridades policiais, mas sem a revelação do motivo que teria levado à retirada da postagem.

Considerando que a remoção de conteúdos se deu no curso de uma investigação criminal sigilosa, parece fazer sentido não avisar ao investigado que ele está sendo investigado. Embora a prática não deva ser trivializada, já que ela pode transformar as plataformas em proxy do Poder Judiciário, ela não transforma o STF em uma corte secreta.

Se por um lado essa indireta acirra os ânimos no debate sobre responsabilidade civil das plataformas, em curso no Supremo Tribunal Federal, algumas das mudanças anunciadas por Zuckerberg não estão lá muito distantes da maneira pela qual os ministros do STF vêm enxergando o tema da moderação de conteúdo.

Zuckerberg afirmou que as ferramentas de inteligência artificial vão passar a se dedicar mais a identificar e a reduzir os erros sobre publicações que representem ofensas graves nas plataformas. Para as ofensas de menor lesividade caberia ao ofendido notificar a empresa para gerar uma atividade de revisão.

Guardadas as devidas distinções, o próprio STF tem buscado delimitar um regime de responsabilidade das plataformas ancorada no grau de lesividade do conteúdo postado, exigindo um maior rigor por parte das plataformas na moderação de conteúdos mais graves, como terrorismo e exploração sexual de menores, ao passo que para outros seria necessário que a vítima notificasse a empresa. Essa distinção aparece nos três votos proferidos até agora no plenário do Supremo.

2. Tudo caminha para mais judicialização

O que não vai faltar é processo. Tanto o STF, com a definição de um novo regime de responsabilidade para plataformas digitais, como a Meta, com o seu anúncio que deve permitir que conteúdos potencialmente lesivos fiquem no ar nas redes, apontam para um futuro em que se processará mais empresas de redes sociais no Brasil.

Nos Estados Unidos, as plataformas possuem uma dupla isenção de responsabilidade, conforme disposto na seção 230 da Lei da Decência das Comunicações, de 1996. Elas não respondem pelo que postam os seus usuários e também não respondem caso moderem conteúdos que lhes pareçam danosos de modo abusivo ou errôneo. O Brasil tem em certa medida parte da primeira imunidade (que está prestes a ser revista pelo STF) e nada da segunda.

É só juntar as peças: o Supremo vai criar um regime de responsabilidade que estimula a moderação de conteúdo para certos temas, enquanto a Meta, de acordo com o anúncio de Zuckerberg, passará a moderar menos em tantos outros. Se por um lado o foco em assuntos graves, como terrorismo e exploração de menores, gera uma coincidência de visões entre o tribunal e a empresa, em tantos outros o sentido é oposto.

Sem a proteção do artigo 19 do Marco Civil da Internet, empresas de tecnologia, e em especial as redes sociais, serão ainda mais processadas pelos conteúdos postados pelos seus usuários.

Como cereja do bolo, caso resolvam cumprir as suas próprias regras e moderar alguma publicação, correm o risco de o autor da postagem processar por violação da liberdade de expressão, como já ocorre nas centenas de casos que hoje tramitam no Judiciário.

3. Quais são as fontes das notas da comunidade?

Um dos pontos de destaque do anúncio de Zuckerberg foi a introdução de um sistema de notas de comunidade, como o que existe no X, permitindo que os próprios usuários passem a explicar, dar contexto ou retrucar o conteúdo postado nas redes.

Zuckerberg anunciou essa mudança como uma resposta ao programa de checagem de fatos desenvolvido pela empresa, que, no seu entender, teria sido capturado por um viés político.

Duas curiosidades sobre essa mudança. Primeiro que ninguém tem um modelo "padrão ouro" sobre notas da comunidade ou moderação de conteúdo descentralizada. A própria Wikipedia, que por décadas implementa um modelo de usuários-editores, é frequentemente criticada pela falta de diversidade no grupo de usuários que toma decisões sobre o que fica ou não no ar na enciclopédia.

As notas da comunidade do X, por sua vez, parecem espelhar muito facilmente uma visão de mundo coerente com aquela que agrada ao dono da plataforma, revelando um problema importante de captura.

Em segundo lugar, como bem lembrou Casey Newton, não raramente as notas de comunidade citam como referência para as suas explicações os sites de agências de checagem de fatos. As mesmas agências que agora foram cortadas do programa da Meta.

4. Quem responde pelas notas da comunidade?

Algumas questões jurídicas interessantes surgem a partir da ascensão do modelo de moderação de conteúdo descentralizado, como as notas da comunidade. Caso a explicação dada pelos usuários seja enganosa ou mesmo lesiva, a empresa responderia por esse conteúdo independentemente de ordem judicial?

Ao mesmo tempo, será que poderia/deveria a empresa intervir na explicação que tenha se mostrado vencedora na discussão entre os usuários, sendo transformada assim em nota da comunidade? Quanto mais a empresa atravessa a explicação e o contexto oferecido pelos usuários - moderando os moderadores de conteúdo - mais ela pode desestimular que eles se voluntariem para essa função.

Quanto mais próximo estivermos das eleições presidenciais de 2026, inclusive, maior será a atenção do TSE para o funcionamento desses modelos de notas da comunidade. Se o foco das regras eleitorais para 2024 recaiu no uso da inteligência artificial, podemos esperar que, em alguma medida, o TSE vai endereçar o tema nas regras para as eleições de 2026, especialmente considerando o impacto das explicações que os usuários farão em publicações de candidatos e de teor político.

5. Bloqueio é coisa nossa

Chama atenção o quão rápido as pessoas passaram a conjecturar que a implementação das novas regras de moderação pela Meta poderia levar ao bloqueio das plataformas da empresa no Brasil, usualmente espelhando o caso do X (antigo Twitter).

O X e o conjunto de aplicativos da Meta (incluindo Facebook, Instagram e WhatsApp) não poderiam ser animais mais diferentes. Tanto no que diz respeito ao número de usuários, como à quantidade de atividades empresariais que são desenvolvidas nas redes da Meta, a comparação com o X não dá nem para o começo. A Meta é uma empresa muito maior e cujo bloqueio de aplicações causaria um impacto maior do que aquele ocorrido com a suspensão do X.

Vale tomar cuidado para não se trivializar a conversa sobre bloqueio, ainda mais quando as medidas anunciadas por Zuckerberg sequer foram implementadas. A tendência em se recorrer imediatamente ao bloqueio também desconsidera que essa medida é a ferramenta mais drástica que o Poder Judiciário tem ao seu dispor e que até lá existem várias outras soluções que podem levar à adequação das atividades das empresas de tecnologia estrangeiras com a legislação nacional.

6. A estratégia vai funcionar?

Por fim, vale questionar o quanto a mudança de postura da Meta faltando alguns dias para a posse de Donald Trump para um segundo mandato terá o condão de arrefecer os ânimos do presidente com relação à empresa. Elon Musk, dono do X, fez esse movimento com mais de um ano de antecedência e, se juntando na campanha vitoriosa de Trump, hoje ocupa uma posição no governo norte-americano.

A Meta possui em sua alça de mira uma ação antitruste e a irritação de várias lideranças do Partido Republicano por medidas de moderação de conteúdo reputadas por elas como censura. Ao se aliar ao discurso republicano e fazer um mea culpa, a empresa se junta em um esforço governamental e do setor privado norte-americano para fazer frente à competição da China no campo da inovação e à Europa no campo da regulação.

Existem ganhos tanto para Trump como a empresa nesse alinhamento, mas será interessante acompanhar o quanto o anúncio sobre novas regras na moderação de conteúdo efetivamente vai converter as desconfianças do grupo republicano, que se acostumou a ver nas práticas da empresa um alvo para protestar sobre censura na Internet.

Vale lembrar que a Meta não está abandonando as atividades de moderação de conteúdo, como inclusive chegou a se reportar por aí. As mudanças não são pequenas e nem um pouco isentas de controvérsias, mas a depender da calibragem e da velocidade com que elas forem implementadas, a empresa pode se ver uma situação em que ela acirra as tensões com governos locais pelo mundo afora (inclusive no Brasil) e não escapa inteiramente de pressões internas.

Especialmente porque a moderação de conteúdo nunca é perfeita, sempre haverá conteúdos que deveriam ter sido removidos e ficaram no ar, e outros que foram retirados de forma inapropriada. Em tempos de redes sociais são os erros - e não os acertos - que geram mais compartilhamento, visualizações e toda sorte de engajamento.

Deixe seu comentário

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Leia as Regras de Uso do UOL.