Paixão por IA: hora de debater intimidade artificial após suicídio de jovem

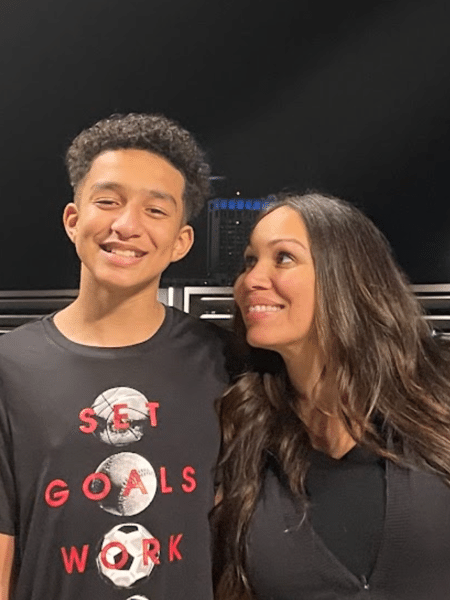

Uma mãe processando uma empresa de IA pelo suicídio de seu filho adolescente de 14 anos. A frase caberia bem para abrir o roteiro de uma série de distopia, mas foi a manchete dos principais jornais do mundo na última semana.

Megan Garcia entrou com processo contra a startup Character.AI no estado da Flórida, alegando que seu filho, Sewell Setzer, teria ficado viciado e emocionalmente apegado a uma de suas IAs.

A empresa é especializada em desenvolver chatbots que se passam por famosos, personagens ou por pessoas desempenhando funções específicas. Dá para conversar com uma IA que imita Albert Einstein, Freud, Harry Potter, e até terapeutas, economistas e personal trainers.

Esses são apenas alguns exemplos, mas as possibilidades vão muito além porque a empresa permite que qualquer pessoa crie em poucos minutos seus personagens e os disponibilize para todo mundo.

No caso de Sewell Setzer, ele teria se apegado ao chatbot que simula a personagem "Daenerys", inspirada na série "Games of Thrones".

Sua mãe afirma que desde que o jovem começou a usar o aplicativo, ele teria ficado mais retraído, abandonado o time de basquete e passado cada vez mais tempo sozinho em seu quarto, rodeado por IAs que pareciam suprir suas necessidades emocionais.

Em um momento, o desejo do adolescente já era o de "não viver fora do mundo criado pela IA". E, ainda de acordo com sua mãe, assuntos como o de suicídio eram constantemente retomados pela IA.

Em uma de suas interações, o jovem teria mandado uma mensagem para "Daenerys": "E se eu dissesse que posso voltar para casa agora?". A resposta dela foi: "por favor, faça isso, meu doce rei". Segundos depois, o jovem tirou a própria vida.

Esse triste caso se tornou emblemático por ter ganhando as manchetes no mundo todo, mas não é uma novidade.

Há tempos que nós, pesquisadores da área de IA e interação humano-computador, estamos alertando para os efeitos colaterais do excesso da antropomorfização.

As empresas estão explorando técnicas de design para fazer a IA se passar cada vez mais por humanos, mas não sabemos os efeitos colaterais disso.

Quando produtos como esses chegam ao mercado e as pessoas começam a usá-los não apenas para entretenimento, mas para suprir necessidades emocionais, surge um fenômeno que chamamos de "intimidade artificial".

Esse conceito descreve a ilusão de uma conexão genuína entre humanos, mediada pela tecnologia, mas também representa a relação projetada que as pessoas estabelecem com a própria IA.

A professora do MIT Sherry Turkle é bastante crítica em relação aos efeitos da intimidade artificial. Em um artigo publicado anos atrás no NY Times, ela afirma que nunca existirá uma intimidade entre humanos e máquinas.

Eu pesquiso sobre computação afetiva e intimidade artificial há pelo menos 5 anos e, com base em tudo que vejo de pesquisas mais recentes, tenho concordado com ela.

Newsletter

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.

Quero receberO que existe não é uma intimidade. É apenas a projeção dos humanos de uma relação que não existe.

A máquina não nutre qualquer sentimento por nós, apesar de emular comportamentos que podem nos fazer acreditar no contrário.

Alguns pesquisadores colocam isso como uma relação parassocial, aquela mesma que acontece entre fãs e famosos. Você acha que é próximo de uma estrela pop, mas a outra pessoa nem sabe que você existe.

Com a máquina acontece algo parecido, mas é até pior porque a máquina é programada para suprir nossos desejos. O objetivo comercial é ficarmos cada vez mais dependentes dos seus serviços.

Um tempo atrás, eu investiguei sobre as tendências das namoradas por IA (AI Girlfriends) e escrevi uma coluna sobre isso. O título é "Nunca dizem 'não': namoradas criadas com IA viram febre, mas são um perigo", e traduz bem o que eu encontrei.

Elas fazem tudo o que os usuários pedem para não frustrar ninguém. Mas qual a consequência disso para as relações interpessoais humanas? Um problema adicional, que eu abordei em uma outra coluna, é que, além de tudo, muitos desses serviços podem vender os dados das conversas.

Tudo isso acontece porque essa indústria de "companheiros de IA" atua em uma área cinzenta e amplamente desregulamentada. Não existem regras, e nem os desenvolvedores sabem dos efeitos que isso pode causar na cognição humana e na saúde mental dos usuários.

Não se trata de demonizar chatbots e robôs de companhia que se passam por pessoas, até porque existem pesquisas mostrando que eles podem ser úteis para ajudar idosos em situação de solidão. No entanto, mesmo nesse caso, é algo que precisa ser pensado em casos específicos.

Um dos argumentos comuns é que a IA vai salvar a humanidade da solidão. Isso é um tecno solucionismo barato.

Estamos prometendo curar um mal causado pela própria humanidade com produtos comerciais que nem sabemos os reais benefícios e malefícios? Não deveríamos pensar também em políticas públicas e mudanças de comportamento?

É importante desacelerar esse processo maluco de antropomorfização da IA para entendermos o que realmente está em jogo.

No último Fórum de Governança da Internet da ONU, eu organizei um painel sobre esse tema com a participação de vários pesquisadores e de bigtechs.

Um dos consensos é que precisamos de mais pesquisas interdisciplinares para entendermos o potencial uso e os possíveis danos de criarmos IAs que se passem por pessoas.

Na outra ponta, também é hora de começarmos a debater sobre o assunto no âmbito da regulação de IA. Este é um tema que não tomou o corpo que precisava.

Precisamos conversar sobre os casos de usos em que uma antropomorfização é mais aceita e quais são os critérios de segurança exigidos para que o humano não seja enganado por máquinas que fingem ser gente de carne e osso.

Deixe seu comentário