Texto em que o autor apresenta e defende suas ideias e opiniões, a partir da interpretação de fatos e dados.

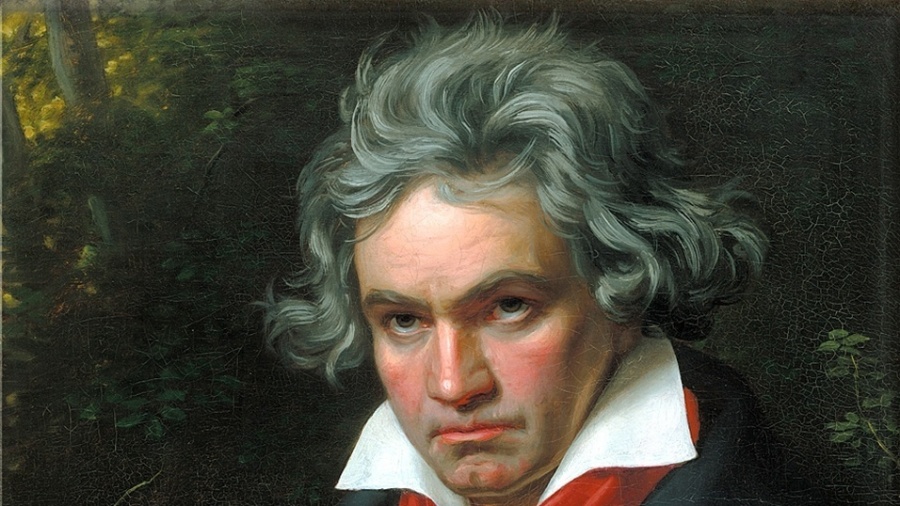

IA terminou sinfonia que Beethoven deixou. Sacrilégio? Vem mais por aí

Receba os novos posts desta coluna no seu e-mail

A décima sinfonia de Beethoven foi apresentada pela orquestra Ensemble Prisma, em Caríntia, Áustria, no sábado passado (10). Seria apenas mais uma exibição de música clássica num festival de verão, não fosse por um detalhe: Beethoven nunca concluiu essa sinfonia. O que o público ouviu foi uma composição produzida por uma inteligência artificial.

Não foi sua primeira exibição. Ela estreou em 9 de outubro de 2021 (ouça a sua primeira versão aqui), em Bonn, na Alemanha, nas comemorações do 250º aniversário do compositor.

A obra nasceu da parceria entre várias instituições e levou mais de dois anos para ser concluída. A matéria-prima foram os 40 esboços da sinfonia jamais concluída na quase indecifrável caligrafia de seu autor.

Quando o projeto começou, a maioria das inteligências artificiais era incapaz de cumprir essa missão, segundo Ahmed Elgammal, professor de ciência da computação da Rutgers University e um dos envolvidos no trabalho.

Na tentativa de acertar a mão, ele reuniu compositores, musicólogos e historiadores musicais, com a intenção de ensinar ao computador os maneirismos do gênio alemão.

Karin Waldner-Petutschnig, do jornal austríaco "Kleine Zeitung", esteve na apresentação de sábado e registrou que o público não se derramou em aplausos para essa versão "meio homem, meio máquina", mas se entusiasmou com a execução da quinta sinfonia com instrumentos de época.

Para os colunistas, que não vão muito além do tchã-tchã-tchã-tchã em termos de música clássica, importa mais assinalar que as aplicações da IA no campo da música têm crescido muito.

Algumas pistas:

- Playlists no Spotify Discovery e YouTube

As playlists que você escuta no Spotfy Discovery ou YouTube são construídas por IA.

As plataformas partem de suas preferências e audições para oferecer um cardápio que entende ser adequado ao seu gosto. Isso pode fazer com que você consuma mais do mesmo, mas evita desagradar o ouvido de um fã de sertanejo com uma sinfonia (ou vice-versa).

- Músicas de IA no StarX MusicX Lab e... nos cinemas?

A plataforma StarX MusicX Lab, da gigante chinesa Kunlun Tech, acaba de lançar cinco músicas, todas compostas por software de IA, e quer agora produzir trilha para games, filmes e outras obras, sem a participação de humanos.

Quando usamos o adjetivo gigante, é gigante mesmo: no final de 2021, os negócios da Kunlun Tech abrangiam mais de 100 países e regiões, com quase 450 milhões de usuários ativos mensais. O lucro operacional do ano passado foi de 4,85 bilhões de yuans (US$ 666 milhões).

- Investimentos para IA com "talento musical"

No Reino Unido, a DAACI, (Definible Aleatoric Artificial Composition Intelligence), um sistema de IA que compõe, organiza, orquestra e produz música original da mais alta qualidade, recebeu apoio financeiro de 250 mil libras (US$ 300 mil) de um fundo público, o Innovate UK, e está em campanha para arrecadar quatro milhões de libras até setembro.

- Roqueiro IA virou unicórnio

Em Luxemburgo, a Aiva Technologies que começou produzindo música clássica com IA e lançou seu primeiro rock, "On the Edge", em 2018, se tornou um unicórnio, isto é, uma startup avaliada em um milhão de dólares.

Para Paulo, o rock criado pela Aiva, está mais para Renato e seus Blue Caps (só quem viveu sabe do que se trata) do que para Beatles ou Rolling Stones. Pedro também não se entusiasmou muito com o ritmo da composição.

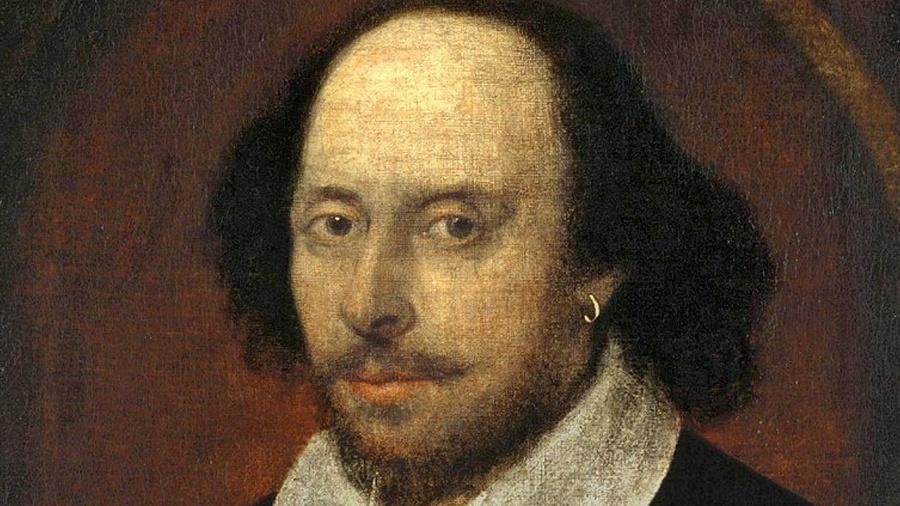

Mas vale anotar que Aiva foi a primeira artista virtual a registrar suas criações em uma sociedade de direitos autorais (SACEM). Seus criadores dizem que Aiva continuará incentivando a colaboração homem-máquina e que não irá substituir os músicos.

Está certo. Mesmo que Beethoven tenha composto parte de sua obra nos últimos oito anos de sua vida, quando já não escutava nada, entre sua Nona e a tal Décima Sinfonia, ainda há uma estrada a percorrer.

Criando música com dados, mas sem áudio

Na maioria das pesquisas atuais, a IA que cria música não gera som bruto diretamente, mas símbolos que representam a canção. O MIDI, por exemplo, é um padrão para transferir e compartilhar dados de performance de instrumentos musicais eletrônicos entre dispositivos. É equivalente a uma partitura musical. Tudo isso em um formato de dados que podem ser processados por um computador.

O MIDI tem a vantagem de ser leve e fácil de manusear por não conter áudio, mas é necessário converter a música para MIDI para usá-lo como dados de treinamento para modelos de IA.

Há aproximadamente 400 mil músicas no formato MIDI e isso não é suficiente para algumas aplicações.

Outra questão é o tempo que demanda a produção de um segundo de música.

Há formatos mais adequados para uso em sistemas de geração de música simbólicas, como o REMI, que acrescenta informações como a posição da nota em relação a cada compasso, andamento e acordes, permitindo assim que o modelo aprenda mais estruturas musicais durante o treino.

E também existe o MuMIDI, desenvolvido para o aprendizado efetivo de multifaixas, em que cada faixa corresponde a um instrumento, com ênfase na relação polifônica entre notas em diferentes faixas. A ideia é soar o mais natural possível uma música com várias faixas.

Novo rap do Kanye West? Não é bem assim

O Jukebox, uma ferramenta que compõe e gera arquivos de áudio WAV, que podem ser reproduzidos diretamente, baseia-se num modelo de aprendizado profundo treinado a partir de mais de 1,2 milhão de músicas.

Pode fazer Céline Dion cantar um samba, Frank Sinatra entoar "It's Christma's Time", Kanye West fazer rap no estilo Eminem, mas exige cinco horas de computação para cada segundo.

Outro campo em que há avanços importantes é o das fontes sonoras necessárias para que se ouça a música composta sem a participação humana.

Geralmente são sintetizadores e samplers. Os primeiros geram o som eletronicamente, enquanto um sampler mistura ou remixa sons já gravados.

A equipe Magenta do Google, pioneira na pesquisa de música de IA, desenvolveu o NSynth, que modela vários sons usando uma arquitetura de aprendizado profundo, que é capaz de capturar quantitativamente diferenças de timbre, permitindo a criação de sons como o que estaria entre o de uma cítara e de uma marimba, por exemplo.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.