Máquina "caçadora de viés" surge para combater as máquinas preconceituosas

Resumo da notícia

- Máquinas podem se tornar racistas, machistas e preconceituosas

- Falhas assim geram desconfiança e afetam a demanda por produtos

- Nova tecnologia é capaz de detectar essas distorções

Se você gosta de contato humano, é bom ir se acostumando a um mundo cada vez mais dominado por máquinas que tomam decisões cruciais sobre a sua vida. Pelo mundo, sistemas de inteligência artificial (AI) já decidem quem deve sair da cadeia, dão informações sobre sua conta corrente, vendem apólices de seguro e identificam seu rosto para decidir se você é mesmo quem diz ser. Mas e se essas máquinas espertinhas, por algum motivo, não forem com a sua cara e resolverem complicar bastante esses processos?

Essa possibilidade é tão real que virou um fator de risco para o negócio das empresas que querem fazer a inteligência artificial pegar. E o motivo é simples: máquinas que tomam decisões enviesadas geram uma tremenda desconfiança sobre o que estão fazendo.

"Desafios éticos"

"Uma das coisas certas de qualquer tecnologia é que ela tem propensão a falha. Não existe tecnologia que vá te dar 100% de assertividade em tudo", ressalta Paula Assis, presidente da IBM na América Latina:

Se a gente não conseguir resolver a questão do viés e explicar como as decisões são tomadas, vai ser muito difícil criar confiança nas pessoas e empresas para usar essas tecnologias

Para você ter uma ideia, a IBM é a empresa dos sistemas de inteligência artificial que rodam na assistente pessoal do Bradesco, no agendamento da central de serviços paulista Poupatempo e até no processamento de exames do laboratório Fleury.

Outras companhias que também atuam nessa área passaram a avisar seus investidores com cores mais ou menos vivas sobre os problemas que uma inteligência artificial falha podem gerar.

O Google incluiu o assunto pela primeira vez na área dos riscos do negócio de seu relatório financeiro apresentado neste ano. "Novos produtos e serviços, incluindo aqueles que incorporam ou utilizam inteligência artificial e aprendizado de máquina, podem aumentar os já existentes desafios éticos, tecnológicos, legais ou exacerbar novos, o que pode afetar negativamente nossas marcas e demanda para nossos produtos e serviços e ter efeito adverso sobre nossas receitas e resultados operacionais."

A Microsoft já faz isso desde o meio do ano passado, mas já deu uma pista sobre a origem do problema.

"Todos os algoritmos podem ser imperfeitos. As bases de dados podem ser insuficientes ou conter informações enviesadas. Práticas de dados controversas ou inapropriadas pela Microsoft ou outros podem impactar a aceitação das soluções de AI. Essas deficiências podem minar as decisões, previsões e análises que as aplicações produzem, o que nos deixa sujeitos a danos competitivos, responsabilização legal e prejuízo à reputação da nossa marca."

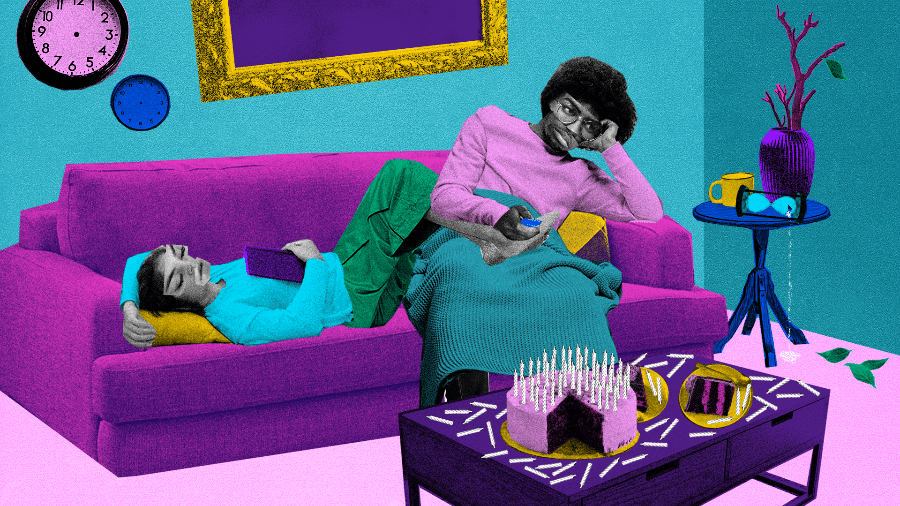

Viés implícito

Quando uma inteligência artificial é acionada, a decisão sai após vários cálculos matemáticos que exigem uma série de códigos de computador capaz de entender quais dados estão sendo processados. O resultado depende ainda das informações submetidas no processo. Como você já deve ter adivinhado pela declaração da Microsoft, as empresas afirmam que, quando algo dá errado, a falha provavelmente ocorreu com os dados lidos pela máquina.

Algumas bases de dados, por exemplo, são completamente falhas, o que traz cenários de preconceito, injustiça e viés

Kelly Combs, diretora de risco de tecnologias emergentes da empresa de auditoria KPMG

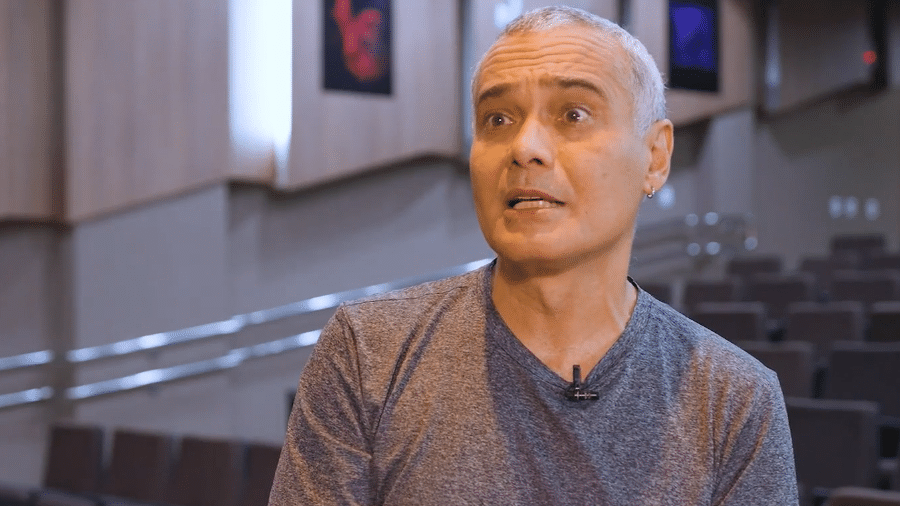

Roger McNamee foi durante 30 anos um megainvestidor em empresas de tecnologia e tornou-se guru dos chefões da área. Hoje é um crítico do modelo de negócio de plataformas de internet que usam dados das pessoas de forma tão intensiva que acabam as tratando como um produto. Algumas empresas, critica ele, não são suficientemente diversificadas para perceber que seus produtos estão cometendo injustiças.

"Não há uma pessoa que diga o seguinte: 'Espere um minuto, se a base de dados que estamos usando para treinar nossa inteligência artificial que lê currículos vem de empresas que possuem vieses implícitos de gênero e raça é claro que a AI vai herdar esse preconceito'."

Ele não afirmou, mas o caso descrito é o de um sistema interno da Amazon. Ela usava um robô inteligente para fazer a triagem de currículos que teve de ser desligado por favorecer candidatos que fossem homens e brancos.

Para auxiliar empresas que querem dar um banho de inteligência artificial em seus negócios, mas receiam que isso seja o mesmo que trancar sua galinha de ovos de ouro dentro de uma caixa-forte cercada de algoritmos indecifráveis, a KPMG até criou uma linha de aconselhamento.

Nós estamos vendo muita empolgação com AI e as implicações que ela pode trazer, mas também há incerteza e preocupação do que pode dar errado, por exemplo, se a AI sair dos trilhos

Kelly Combs

Segundo a diretora, o que ela mais ouve desses clientes é: "Como eu sei se meu sistema de AI é transparente, como eu sei se ele é explicável, como eu sei se posso confiar em uma aplicação de AI?"

A recomendação dada pela consultoria aos interessados em abraçar máquinas inteligentes passa por alguns pilares, como e usar dados íntegros e que não sejam produto de coletas enviesadas e adotar sistemas que possam conversar com outros e que produzam resultados que possam ser explicados.

Um milhão de rostos

Para resolver isso, a IBM criou uma outra máquina, uma espécie de "caçadora de viés". Um exemplo de como ela funciona foi mostrado durante o IBM Think, a conferência anual da empresa.

O exemplo dado é o da Índia, onde cerca de 2 milhões de mortes estão relacionadas a doenças cardíacas, devido à falta de cardiologistas (1 a cada 6.000 pessoas). Uma empresa criou um sistema que informa aos médicos quais pacientes possuem maior probabilidade de sofrerem um ataque cardíaco, assim eles têm o atendimento priorizado. O algoritmo aponta que homens são maioria no grupo de risco. Quando esse serviço é analisado pelo "caçador de viés" da IBM, surge a indicação de que esse dado pode ser enviesado.

Aí entra a segunda parte do trabalho: como corrigir um dado distorcido? Confrontando com outras amostras de informação.

Se a empresa interessada não tiver dados suficientes para conseguir treinar adequadamente suas máquinas inteligentes, é possível que ela receba algum pacote fornecido por empresas interessadas em impulsionar a inteligência artificial. A IBM, por exemplo, ofereceu no fim de janeiro um arquivo com mais de 1 milhão de dados faciais para treinar sistemas de reconhecimento facial.

"Isso aconteceu porque uma instituição de pesquisa veio até nós dizendo que fizeram uma análise das plataformas de reconhecimento de imagem e viram que, para um determinado perfil, o das mulheres negras, há uma taxa de erro muito grande. A gente tomou esse desafio e construiu esse banco", diz Ana Paula Assis, presidente da IBM na América Latina.

Segundo Kelly Combs, da KPMG, "trazer soluções para a mesa vai nos ajudar a superar as limitações e aproveitar o melhor da AI". Dessa forma, talvez seja possível responder com menos desconfiança às perguntas feitas por uma gerente de design do "caçador de viés" da IBM, Reena Ganga:

"Você confiaria a sua vida a uma inteligência artificial? Como a gente sabe se AI vai ajudar a tomar a decisão certa?"

* O jornalista viajou a convite da IBM

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.