Vídeo de Lula e Bolsonaro com deepfake viraliza; você sabe como funciona?

Sem tempo, irmão

- Bolsonaro e Lula aparecem no vídeo como personagens da novela mexicana "A Usurpadora"

- Sátira em vídeo é da autoria do jornalista e editor Bruno Sartori

- Para criar deepfake, computador recebe centenas de fotos e vídeos de uma pessoa

- Máquina opera truque em que imagem do rosto da pessoa B vai ao corpo da pessoa A

Está circulando nas redes sociais um vídeo falso, com a técnica deepfake, com o presidente Jair Bolsonaro no corpo de Paulina, personagem da novela mexicana "A Usurpadora" (1998), e o ex-presidente Luiz Inácio Lula da Silva no corpo de Paola Bracho, irmã de Paulina, conversando por telefone sobre a saída de Lula da prisão. Mas você sabe o que é e como funciona o deepfake?

O termo surgiu pela primeira vez em dezembro de 2017, quando um usuário do Reddit com esse nome começou a postar vídeos falsos de celebridades famosas fazendo sexo, como Emma Watson e Emma Stone. Com auxílio de ferramentas de inteligência artificial, ele colocava o rosto de quem quisesse em cenas já existentes.

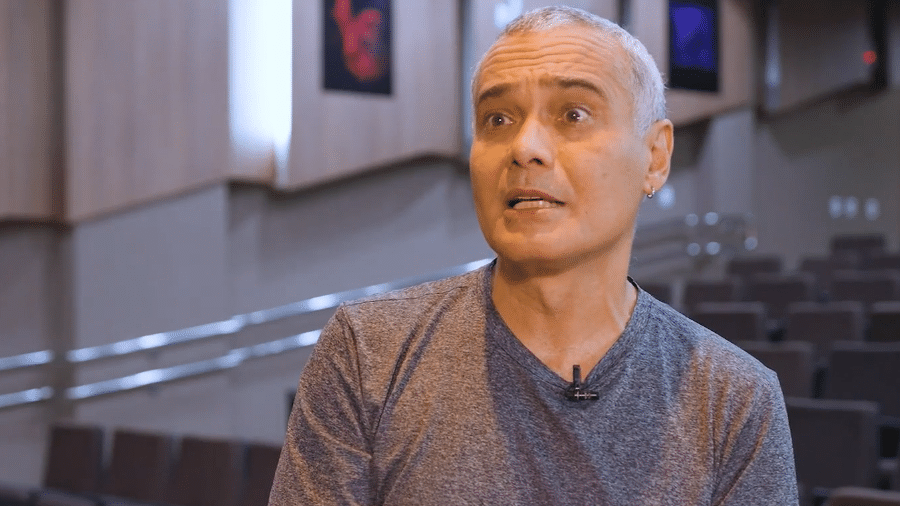

O vídeo desta semana é da autoria do jornalista e editor de vídeos Bruno Sartori. Outras produções suas já viralizaram nas redes sociais, a maioria delas em paródias de acontecimentos políticos. Teve Bolsonaro fantasiado de Chapolin Colorado se atrapalhando em seu discurso; o rosto do presidente no corpo da rainha da Inglaterra, Elizabeth II; e o ministro da Justiça Sergio Moro de melindrosa, dançando Charleston.

Como funciona?

Para criar um deepfake, são utilizados programas de código aberto —ou seja, de livre uso por qualquer pessoa— voltados ao aprendizado de máquina. O programador fornece centenas de fotos e vídeos das pessoas envolvidas que são automaticamente processados em rede. Desse modo, o computador aprende como é determinado rosto, como ele se mexe e como ele reage a luz e à sombra.

O software precisa aprender essas características do rosto do vídeo original e do rosto que deseja ser implantado, pois só assim o programa pode encontrar um ponto comum entre as duas faces. Feito isso, a máquina realiza uma espécie de truque em que a imagem do rosto da pessoa B é colocada no corpo da pessoa A.

Em entrevista ao canal do YouTube do site E-farsas, Bruno Sartori falou sobre a técnica. "Há cerca de um ano, eu precisava treinar um rosto por cerca de 30 dias. Hoje, a tecnologia já evoluiu e com cerca de três a quatro dias, eu consigo ter o mesmo resultado", afirmou o jornalista.

Efeitos especiais de computador para criar rostos e cenas no audiovisual já não são novidade. Por exemplo, o ator James Dean, morto em 1955, deve ser recriado digitalmente para estrelar o filme "Finding Jack" em 2020. O problema está na facilidade em que o deepfake pode ser produzido atualmente.

Comparado ao que era antes, qualquer um com acesso a algoritmos, conhecimento de aprendizado de máquina e um bom processador gráfico pode criar um vídeo falso bastante convincente. Até mesmo um app chinês para celular chamado Zao já começou a experimentar com a técnica.

Além disso, o deepfake já foi utilizado em pornografia de vingança (do inglês, revenge porn) e pode ser em breve usado amplamente como arma política. Nos Estados Unidos, um vídeo do ex-presidente Barack Obama proferindo xingamentos contra o atual presidente Donald Trump viralizou no ano passado. Há também vídeos falsos de Trump falando sobre como algoritmos o ajudaram a chegar à Casa Branca.

Lei brasileira está preparada para os deepfakes?

É um ponto em aberto ainda. Carlos Affonso, diretor do ITS (Instituto de Tecnologia e Sociedade) e professor da UERJ, não acha que uma lei específica é necessária para deepfakes. Já para Lucia Santaella, coordenadora do doutorado em tecnologia da inteligência e design digital da PUC-SP, a legislação existente não dá conta de julgar deepfakes.

Por isso, a organização global Witness, que promove o uso da tecnologia de vídeo na defesa de direitos humanos e no jornalismo cívico, publicou neste ano o relatório "Deepfakes no Brasil - Prepare-se agora" para combater que tais conteúdos se propaguem como verdadeiros.

Entre as medidas propostas estão:

- A conscientização dos brasileiros sobre tecnologias que potencializam a viralização de conteúdos falsos. Assim, as chances de alguém questionar a veracidade do que se recebe aumentam

- A criação de ferramentas mais precisas de detecção que sejam "claras, transparentes e confiáveis"

- O desenvolvimento de ferramentas acessíveis para que as pessoas consigam verificar por elas mesmas a autenticidade de vídeos

- Grandes plataformas web como Facebook, YouTube, Google e Whatsapp precisam fazer parte da solução com transparência e apoio para separar a verdade da falsidade

SIGA TILT NAS REDES SOCIAIS

- Twitter: https://twitter.com/tilt_uol

- Instagram: https://www.instagram.com/tilt_uol/

- WhatsApp: https://uol.page.link/V1gDd

- Grupo no Facebook Deu Tilt: http://bit.ly/FacebookTilt

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.