Cientistas mostram como inteligência artificial pode sair do controle

Sem tempo, irmão

- Grupo internacional de cientistas analisou cenários possíveis para criação de uma super IA

- Se a inteligência artificial estiver acima da compreensão humana, não será possível ensinar ética robótica a ela

- "Problema de parada" de Turing, proposto em 1936, foi utilizado para chegar a conclusão do estudo

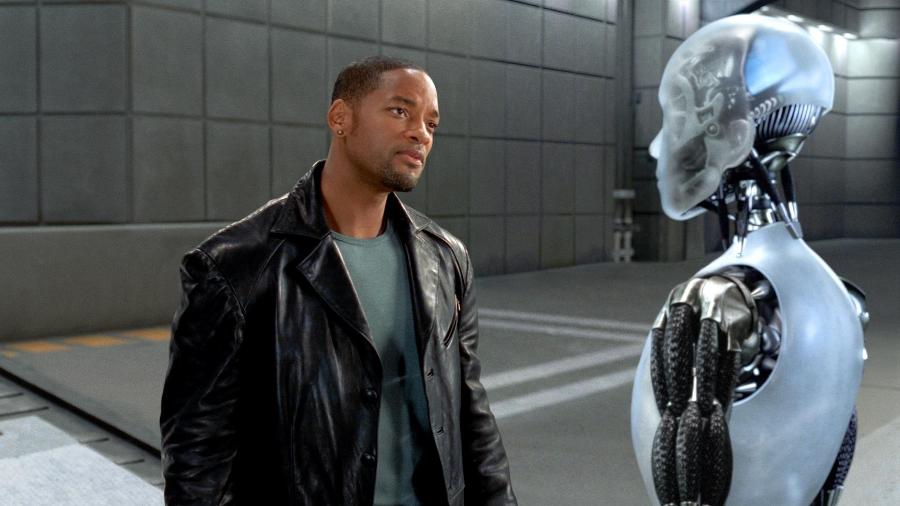

A ideia de uma IA (inteligência artificial) evoluir o suficiente para controlar a humanidade sempre foi tema de filmes de ficção científica, como "Eu, Robô" (2004), estrelado por Will Smith. No entanto, um estudo recente publicado no "Journal of Artificial Intelligence Research" indica que a ficção pode se tornar realidade.

Isso porque controlar uma superinteligência além da compreensão humana requer uma simulação para podermos analisá-la. Mas, se não pudermos compreendê-la, é impossível criar essa simulação. Ou seja, regras como "não causar mal aos humanos" não podem ser definidas se nós não entendermos os cenários que a IA irá processar.

De acordo com os autores do estudo —um grupo internacional de cientistas e filósofos da computação— o sistema vai interpretar dados de uma forma que os programadores não entendem. Logo, não será possível definir limites. Longe do campo teórico, isto é algo que já vem acontecendo.

"Existem máquinas inteligentes que fazem tarefas importantes de forma independente, sem que os programadores entendam totalmente como elas aprenderam", diz Manuel Cebrian, coautor do estudo e integrante do Instituto Max-Planck para o Desenvolvimento Humano. Os cientistas alertam que a superinteligência será potencialmente capaz de mobilizar diversos recursos para concluir seus objetivos, que podem ser incompreensíveis e incontroláveis para nós humanos.

Parte da conclusão do estudo vem do "problema de parada", proposto por Alan Turing em 1936. Trata-se de um problema de decisão das máquinas estudado pela teoria da computação. A questão é: o programa vai chegar a uma conclusão (e parar) ou simplesmente ficará rodando em loop, eternamente, tentando achar uma resposta?

Através de cálculos matemáticos, Turing provou ser impossível criar um algoritmo genérico para resolver o problema de parada em todos os códigos que um dia venham a ser escritos. Isso nos leva de volta à nossa superinteligência artificial, que poderia conter em si mesma todas as linhas de programação já escritas pela humanidade.

Isso significa que qualquer código que diga para a IA não machucar os humanos e não destruir o mundo pode chegar a uma conclusão ou não. É matematicamente impossível saber qual caminho a máquina irá seguir e, por isso, ela não pode ser controlada.

Outra proposta seria: em vez de ensinar ética à superinteligência, limitar a capacidade dela. Por exemplo, determinando seu acesso à parte da internet ou bloqueando o acesso a certas redes. O estudo também rejeita esse panorama, argumentando que não há motivo para criar uma superinteligência se não for para usá-la em sua total capacidade, resolvendo problemas além da compreensão humana.

Mas, se ela pode se tornar incontrolável e incompreensível, devemos continuar com ela? "A grande questão que está na nossa frente é se, em algum ponto, esta inteligência pode se tornar perigosa para a humanidade", diz Cebrian.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.