Startup cria 'Big Brother' com inteligência artificial contra crimes no RJ

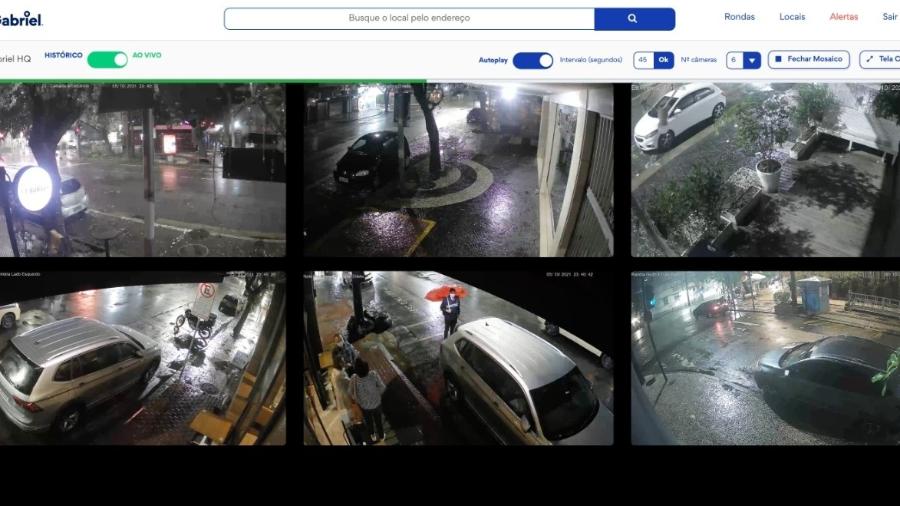

Se for andar pelos bairros de Ipanema ou Leblon, na Zona Sul do Rio de Janeiro, sorria, você provavelmente estará sendo filmado em uma espécie de "Big Brother" tecnológico. Uma startup brasileira tem instalado nas duas regiões cariocas cerca de 1.500 câmeras que utilizam IA (Inteligência Artificial) para monitorar eventuais riscos de crimes contra prédios, condomínios e residências.

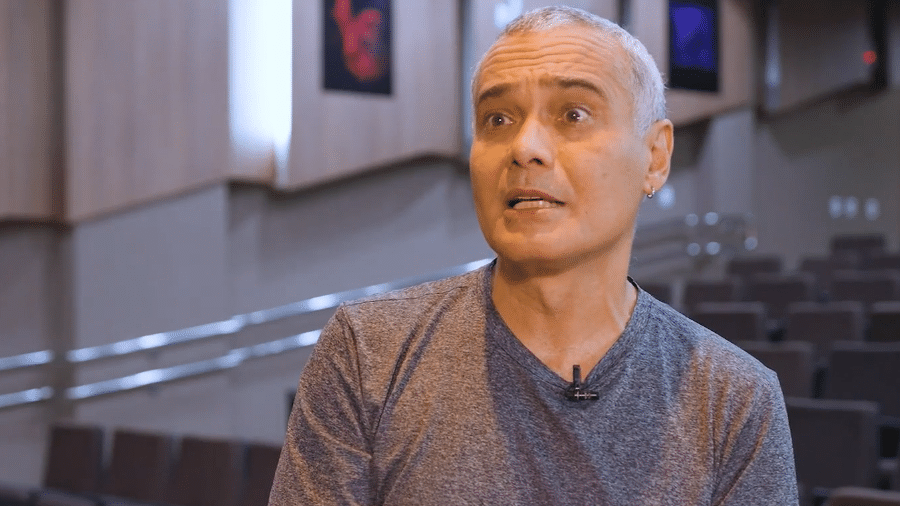

As câmeras em questão foram instaladas nos últimos quase dois anos na parte interna e externa de imóveis particulares. As tecnologias possuem visão em 180º e são dotadas de um algoritmo que consegue diferenciar imagens de humanos, de objetos e animais, de acordo com Otávio Miranda, cofundador da startup Gabriel — fundada ao lado dos amigos Erick Coser e Sérgio Andrade.

"Se confirmarmos um padrão suspeito, que é arrombamento, saltos por cima de grades ou muros, por exemplo, informamos ao morador, que diz se é comum ou não, e se chamamos a polícia", explica Miranda.

A tecnologia gerou atenção do mercado e a startup conseguiu atrair neste mês R$ 66 milhões de um fundo de investimentos, liderado pelo SoftBank.

Com o dinheiro arrecadado nessa rodada, a empresa quer aumentar a sua infraestrutura para diminuir o valor da assinatura e expandir para outros bairros e cidades. Cada par de câmeras custa R$ 199 por mês para quem contrata o serviço de monitoramento.

Como o algoritmo funciona

O algoritmo nas câmeras é programado para detectar invasões em propriedades particulares, arrombamentos e depredação do imóvel.

Para evitar potenciais erros no monitoramento, após o algoritmo alertar o morador e a central da Gabriel, a ação captada pela IA passa por uma filtragem humana, composta por uma equipe de funcionários da startup. "A primeira coisa que fazemos depois do algoritmo é a checagem", diz.

De acordo com o executivo, a tecnologia é programada para alertar sobre uma ação direta humana e não nas características da pessoa, como a cor da pele ou pela maneira como se veste, padrão alvo de críticas por especialistas, já que tecnologias com inteligência artificial ainda erram bastante e discriminam indivíduos.

"Sem crime, não existe ação posterior. Não podemos ser preditivos. É algo considerado errado em muitos lugares. Não tem como entender quem é um suspeito, pois eticamente está incorreto. O que importa é entender o que aconteceu, sendo desconsiderada a cor da pele. O foco é na ação e não na pessoa", afirma Miranda.

O desafio no mercado de câmeras de monitoramento ainda envolve os chamados "falso positivo", que é quando um alarme de segurança dispara por uma situação que não envolve um crime, como a queda de folhas de árvores ou um animal passou por perto.

A tecnologia com IA usada pela empresa, diz o executivo, foi pensada para evitar o problema.

Dados usados pela segurança pública

Para Miranda, as quase 1.500 câmeras instaladas nas ruas dos dois bairros do Rio de Janeiro permitem criar uma rede de imagens que podem servir de apoio para investigações de crimes pelas forças de segurança pública. A empresa estima que, em 2021, imagens cedidas pela central da Gabriel auxiliou em 140 inquéritos da Polícia Civil do Rio de Janeiro.

Procurada por Tilt, o órgão informou que não tem parceria com a Gabriel e que solicita as imagens de câmeras em prédios ou residências para investigações independentemente da empresa, podendo a startup ser uma das que fornece.

Apesar de tecnologias avançadas, a desembargadora Ivana David, do TJSP (Tribunal de Justiça de São Paulo), alerta que somente uma imagem capturada por uma IA não pode servir como única prova para uma condenação criminal.

"Investigar vai além, pois não deve ser a única prova para uma eventual condenação. Essa tecnologia é apenas um elemento", explica a especialista, que também é professora de direito digital.

A magistrada afirma que, mesmo o suspeito sendo flagrado por IA, é necessário que uma perícia ateste que a pessoa reconhecida pela vítima se trata da mesma eventualmente captada em uma imagem.

"Esse tipo de reconhecimento por imagem captada por empresa privada equivale a um reconhecimento fotográfico. É preciso passar por um procedimento de IA e através da perícia é constatada a autoria. Os erros que vemos na Justiça são os que não fizeram este caminho", ressalta.

Como fica a privacidade de quem é gravado?

De um computador, as imagens são transmitidas de forma criptografada para um banco de dados na nuvem da startup, aos aplicativos dos contratantes e à central de controle da empresa, diz Miranda.

De acordo com a companhia, os dados não são armazenados de forma individualizadas — o que poderia permitir a identificação de indivíduos sem segurança— em razão da privacidade de quem é filmado, como estabelece a LGPD (Lei Geral de Proteção de Dados).

Riscos da IA na segurança privada

O uso da IA no combate e prevenção de crimes não é novidade no Brasil. Estados e municípios já adotaram a tecnologia. Mas não sem questionamentos em razão dos padrões de pessoas suspeitas identificados pelos algoritmos.

De acordo com Edson Prestes, professor do instituto de informática da UFRGS (Universidade Federal do Rio Grande do Sul), os programadores devem se atentar sobre os dados que são inseridos no sistema da inteligência artificial para que não seja reproduzido na tecnologia um preconceito ainda existente na sociedade.

"O algoritmo é um conjunto de instruções que funcionam a partir de dados inseridos humanamente no sistema. Se você coloca dados errados, terá resultados errados", afirma Prestes, também membro do Painel de Cooperação Digital da ONU (Organizações das Nações Unidas).

"Como se define uma ação de arrombamento, uma atitude de risco aos moradores de uma casa? Tudo isso é definido por uma classificação inserida no sistema. É preciso ter cuidado sobre isso, pois os dados de entrada são importantes", acrescenta.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.