Falar não é sentir: linguistas questionam IA 'consciente' do Google

A recente notícia de que um engenheiro do Google foi afastado da empresa após acreditar que uma inteligência artificial havia adquirido consciência traz à tona uma discussão interessante: é possível chegar a essa conclusão apenas conversando com essa IA?

O engenheiro Blake Lemoine disse ter concluído que a inteligência artificial desenvolveu consciência própria justamente ao dialogar com ela. "Reconheço uma pessoa quando falo com uma. Não importa se ela tem um cérebro na cabeça dela, ou se tem bilhões de linhas de código", afirmou Lemoine ao jornal americano Washington Post.

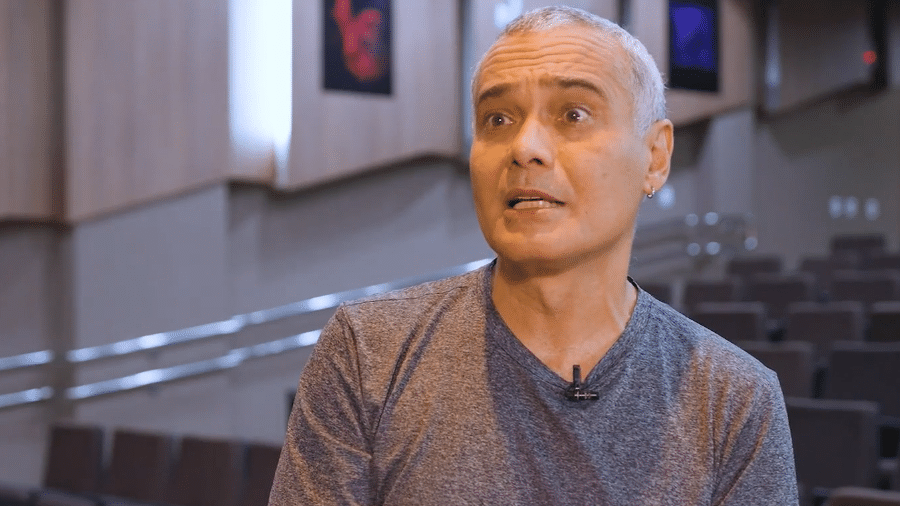

Os linguistas Kyle Mahowald e Anna A. Ivanova estão entre os vários especialistas que questionaram o entendimento de Blake. Mahowald, professor-assistente de linguística da Universidade do Texas, e Ivanova, acadêmica candidata a PhD em ciências cognitivas e cerebrais pelo Instituto de Tecnologia do Massachusetts, explicaram as razões do seu ceticismo em texto para o site The Conversation. Abaixo, um resumo do que eles creem que pode ter acontecido.

Conversar não é sentir

Ao ler a frase que está lendo agora, você deduzirá que ela foi escrita por um humano, não por um robô - e você estará certo. No entanto, é justamente o costume de conversarmos com humanos e não com máquinas que pode nos levar a ficar assustados se uma máquina aprender a responder exatamente como um humano.

Isso nos faz concluir que, se uma inteligência artificial soa como um humano, ela deve pensar e sentir as coisas como um humano. Mas, de acordo com Mahowald e Ivanova, a IA conversacional do Google, apelidada de LaMDA (sigla em inglês para Modelo de Linguagem para Aplicações de Diálogo) é apenas a versão mais sofisticada de modelos para geração de linguagem, que existem desde os anos de 1950.

Esses modelos (chamados de "n-gram") contam a ocorrência de determinadas frases e as utilizam para tentar adivinhar, por meios estatísticos e de probabilidade, quais palavras devem ser usadas em cada contexto. Então, por exemplo, a construção "queijo com goiabada" é mais comum do que "queijo com abacaxi". Logo, a máquina provavelmente utilizará a primeira em vez de empregar a segunda. Mas não quer dizer que ela saiba sentir o sabor do queijo com goiabada, ou com abacaxi - apenas que ela é capaz de conversar sobre isso.

Evolução tecnológica

É claro que a LaMDA e os modelos atuais são muito mais avançados do que os "n-gram" antigos. De acordo com os pesquisadores, o fato de serem treinados na internet dá a eles um contexto muito maior de frases, palavras e expressões para que aprendam como utilizá-las. Além disso, eles são capazes de entender a relação entre palavras distantes umas das outras, e não apenas as palavras que vêm diretamente antes ou depois delas.

Por fim, eles são ajustados por um grande número de "botões" internos - tantos que é difícil até mesmo para os engenheiros que os projetam entender por que eles geram uma sequência de palavras em vez de outra.

Porém, o objetivo das IAs conversacionais, garantem os linguistas, continua igual: prever qual palavra é a mais provável de ser a próxima numa construção de frase. Assim, elas articulam frases que, de tão articuladas e tão "humanas", nos enganam e nos levam a crer que são pessoas reais do outro lado da conversa.

Pegando a IA no pulo

Usando um modelo linguístico similar ao do Google, o GPT-3, os pesquisadores pediram à IA que completasse a frase "manteiga de amendoim e abacaxi". A resposta dela foi, em tradução para o português: "manteiga de amendoim e abacaxi são uma ótima combinação. O gosto doce e saboroso da manteiga de amendoim e do abacaxi complementam um ao outro perfeitamente".

Mas a IA nunca experimentou nem manteiga de amendoim nem abacaxi para expressar esse pensamento. Ela apenas processou todos os textos que existem na internet sobre esses ingredientes e criou um novo texto a partir disso.

Assim, os pesquisadores resolveram pedir para que a IA completasse outra frase: "manteiga de amendoim e penas são gostosos juntos porque?", ao que o modelo respondeu "...porque ambos têm sabores de noz. A manteiga de amendoim é cremosa e macia, o que ajuda a compensar a textura das penas".

Novamente, a IA não foi até o galinheiro e passou manteiga de amendoim numa galinha para comer, para então ser capaz de emitir essa opinião. Isso é o que uma pessoa faria. A máquina apenas seguiu a lógica da construção de uma frase, que pode fazê-la soar exatamente como um humano. Claro, nesse caso, um contexto tão absurdo nos ajuda a ver mais claramente que ela não está pensando e sentindo, apenas respondendo a um estímulo para conversação.

Por fim, os linguistas dizem que a discussão sobre se inteligências artificiais podem ou não adquirir consciência continua, independentemente do artigo que assinam. No entanto, como especialistas, eles afirmam que modelos conversacionais não têm sentimentos reais: "falar fluentemente não significa pensar fluentemente".

*Com informações do The Conversation

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.