Você na sua série favorita? Como o deepfake vai revolucionar cinema e TV

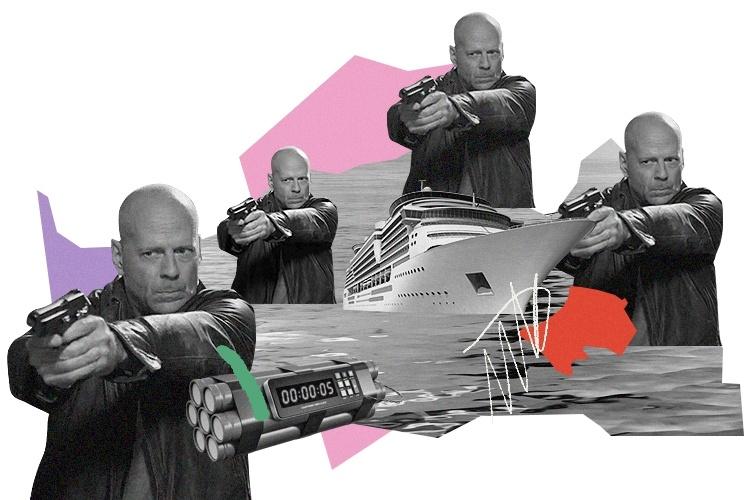

Bruce Willis interpreta mais um cara durão numa grande enrascada. Está preso no mastro de um barco, com uma bomba-relógio prestes a explodir. Sua única chance é interrogar, por telefone, a pessoa que sabe a palavra-chave, em russo, que desarma o explosivo. No último segundo, ele acerta. E o dia está salvo.

Não é uma cena de Duro de Matar: é um comercial russo do ano passado. Mas o ator jamais botou os pés na Rússia para gravá-lo. Aliás, ele nem aprendeu idioma, ou mesmo decorou qualquer fala do roteiro. (Em março, ele foi diagnosticado com afasia, doença que afeta a comunicação.)

O anúncio foi criado com um deepfake: um processo de Inteligência Artificial (IA) que recria rostos e vozes para aplicar no corpo de um dublê. O resultado é tão verossímil que é quase impossível de ser detectado.

Tão mal falado por seu uso em vídeos de pornô de vingança e campanhas de desinformação, o deepfake agora ganha sua oportunidade sob os holofotes de Hollywood. Analistas acreditam que ele pode revolucionar o cinema e a TV, com atores "duplicados", dublagens perfeitamente sincronizadas e até mesmo você estrelando sua série favorita.

Deepfakes ou "gêmeos digitais"?

A "bomba no navio" é apenas uma das 50 vinhetas comerciais que Willis protagoniza para a empresa russa de celulares MegaFon. Ela adquiriu os direitos de imagem do ator e ainda o rejuvenesceu, para que ele "interpretasse" novamente o policial John McClane, seu personagem de Duro de Matar.

Mas não chame esse recurso de "deepfake" na frente da ucraniana Maria Chmir, fundadora da Deepcake, empresa responsável pela campanha. Afinal, não tem nada de "fake" aqui.

"Nós trabalhamos com uma gama de personagens cujos detentores dos direitos de imagem nos deram permissão para usá-las", garante. "Isso inclui, por exemplo, celebridades de Hollywood de alto nível" (ela não revela quais).

A outra metade do termo, "deep", está correta. A Deepcake emprega um processo conhecido como "deep learning" ("aprendizado profundo"), em que redes neurais de dois algoritmos aprendem a reconhecer rostos e reproduzir seus movimentos. Enquanto um recria a imagem pixel por pixel, o outro checa o quão parecido com a original ela está.

Esses algoritmos foram "alimentados" com 34 mil fragmentos de Willis nas mais variadas angulações, condições de luz e expressões faciais. E levou dez dias para elaborar seu "gêmeo digital" — expressão que Chmir acha mais apropriada.

Se depender dela, vai ter estrela com quadrigêmeos por aí. "Imagine: atores não precisarão mais ter que escolher apenas um entre vários projetos interessantes. Eles poderão participar de todos simultaneamente, filmados em diferentes pontos do globo."

A Deepcake também envelhece ou rejuvenesce atores, poupando custos de maquiagem ou de efeitos especiais. Mas o foco da empresa é mesmo criar um grande banco de "gêmeos digitais" de artistas, músicos e influenciadores.

Estrelando: você

"Em pouco tempo, você vai ligar o seu serviço de streaming e quem vai estar atuando ali vai ser você, porque enviou uma foto sua. Pensa isso numa série?"

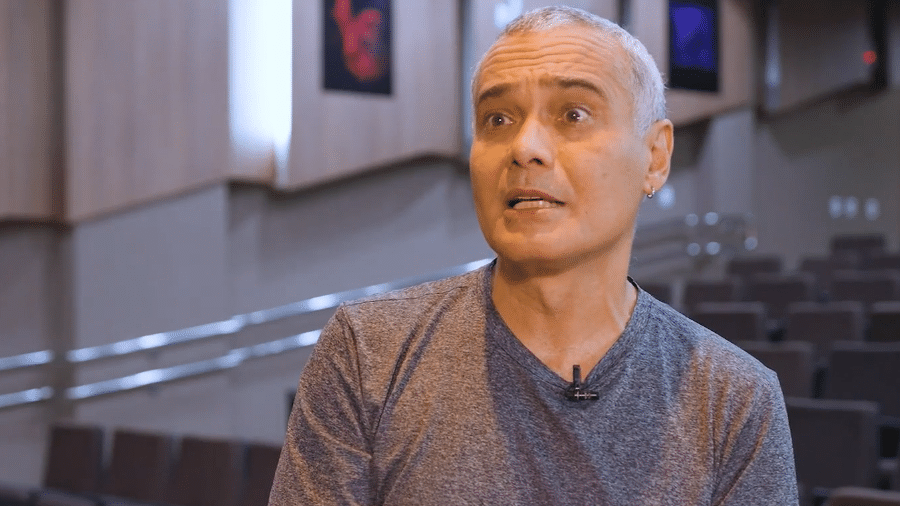

Quem faz essa previsão é Bruno Sartori, o nome mais popular do deepfake no Brasil. O youtuber se especializou em usá-lo em "charges digitais" de cunho político, colocando figuras como Sérgio Moro, Lula e Jair Bolsonaro em cenas pouco prováveis.

Para ele, a indústria demorou para entender o potencial dessa tecnologia. "No cinema, quando você faz a pessoa em 3D e texturiza, é muito caro. O custo do deepfake é infinitamente menor", aponta

Atualmente, ele investe em outra aplicação que também deve ganhar espaço. Sartori pesquisa inteligências artificiais em sua empresa, a FaceFactory, que desenvolve redes neurais capazes de fazer "relabialização" —a sincronização da dublagem com o movimento labial do ator.

Imagine uma cena em que Tom Cruise diz "I love you". No filme dublado, a voz diz "eu te amo", mas os movimentos da boca de Cruise não têm nada a ver com essas sílabas. Com o deepfake, vai parecer que ele realmente articulou cada palavra em português.

Mas e se fosse realmente a voz de Tom Cruise dizendo "eu te amo"? Isso também é possível, como provou o comercial russo de Bruce Willis. Segundo Sartori, as redes neurais que alimentam o deepfake podem captar o timbre de voz do ator e reproduzi-lo naturalmente em outro idioma.

Hoje, porém, o foco da FaceFactory está na inclusão. "É uma técnica que atende a comunidade de pessoas surdas, que fazem leitura labial. Se você tem um conteúdo em inglês, elas não conseguem ler isso ao mesmo tempo, e precisam focar na legenda", explica.

Meryl Streep para sempre

Um dos primeiros usos de deepfake no cinema comercial foi em Star Wars: Rogue One, de 2016. A princesa Leia apareceu em uma versão rejuvenescida da atriz Carrie Fisher.

Fisher faleceu no final do ano seguinte, em meio às gravações de Star Wars Episódio VIII, e suscitou um dilema complexo. Seria possível continuar trazendo-a de volta, considerando que sua gêmea digital já havia sido criada? E mais importante: seria correto?

Em teoria, um ator com suas expressões já capturadas pelo algoritmo poderia continuar a carreira para sempre. Em um mundo assim, jamais perderíamos gente como Meryl Streep, Antonio Fagundes ou Fernanda Montenegro.

As poucas leis envolvendo a tecnologia têm se concentrado no uso indevido de imagem. Mas não há nada sobre como a Justiça deve agir se o direito de imagem da celebridade falecida está nas mãos dos familiares.

"Quando você posa para uma foto, você dá consentimento para um uso específico. Como o deepfake reproduz uma imagem a partir de várias imagens embrionárias, elas serão sempre inéditas. Você está criando imagens inéditas sem sua autorização", analisa Filipe Medon, à época, professor substituto de direito civil na Universidade Federal do Rio de Janeiro e integrante do grupo que reformula o texto da Lei de Inteligência Artificial no Brasil.

O hype estará na 'realidade'

Como com qualquer nova tecnologia, há sempre o medo de que ela irá erradicar o que veio antes. Veremos filmes em que todos os atores são gêmeos digitais?

"Não me incomoda a ideia de que existam pessoas que prefiram ver simulacros. E eu também verei simulacros. Só gostaria de ser informado que estou diante de um", afirma Fábio de Paula, professor da PUC/SP e doutor na área de design digital.

Sartori, que também atua como ativista no tema, concorda que é importante deixar tudo às claras. Quanto mais as pessoas verem e saberem que algo é deepfake, mais serão treinadas para reconhecê-los - em conteúdos de desinformação política, por exemplo.

Para Paula, filmes editados com IAs serão um nicho, como o que já existe na pornografia. No circuito comercial, ele será entendido de maneira similar a outras técnicas de animação.

"Tenho certeza de que eu vou continuar preferindo ver aquilo que foi feito por humanos, não por robôs, ou simulacros. Eu prefiro ver gente", pontua.

A própria Chmir concorda. "É bem possível que logo nós estaremos pagando não para uma geração de cópias digitais, mas para que o conteúdo que consumimos seja 'real'", comenta. "Ir ao cinema ver filmes com atores de verdade nesta nova realidade se tornará algo exclusivo."

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.