Ela saiu do Google para acabar com robôs assassinos - sim, eles já existem

Robôs completamente autônomos tomando a decisão de caçar e matar alguém já são realidade em 2022. Não estamos falando de máquinas humanoides como no filme "O Exterminador Do Futuro", mas de drones munidos de câmeras de reconhecimento facial, armas e inteligência artificial avançada o suficiente para o robô decidir se alguém deve ou não morrer.

O uso de armas autônomas, no entanto, preocupa muitos especialistas, que acreditam que máquinas não são confiáveis e, portanto, podem cometer erros. E, neste caso, erros que podem significar a morte de civis inocentes.

É por isso que foi criada a campanha Stop Killer Robots, que advoga para que as nações regulamentem ou proíbam o uso de tecnologia autônoma em cenários de guerras.

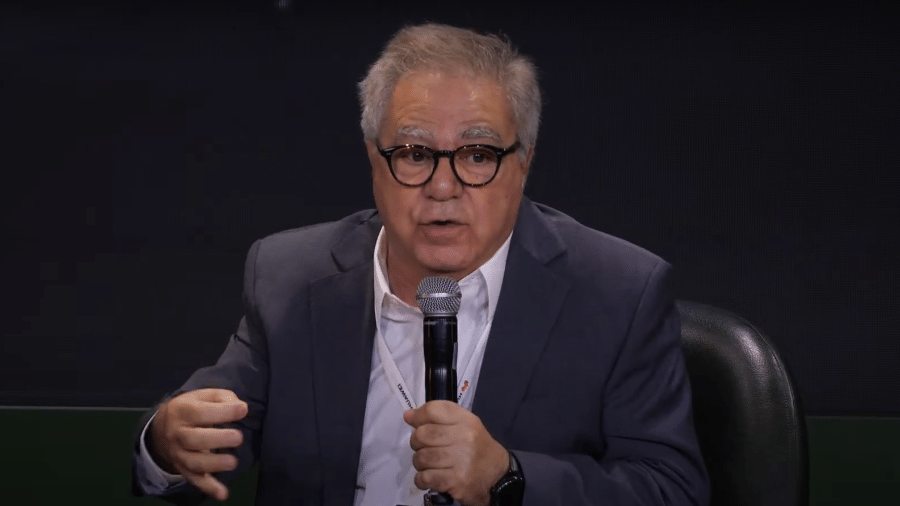

Uma das principais vozes da campanha é Laura Nolan, engenheira que trabalhou por anos no Google até ser escalada para o Project Maven, iniciativa da empresa em parceria com o Pentágono, que utilizava inteligência artificial para analisar imagens de drones. Nolan entendeu o perigo, saiu do Google e, desde então, adverte sobre os riscos da combinação de inteligência artificial e guerras. Confira a entrevista exclusiva de Nolan para Tilt:

Tilt: Já há exemplos de uso de armas autônomas em guerras?

Laura Nolan: Sim. Um deles é uma arma chamada Harpy, que é feita por uma empresa israelense chamada IAI. É uma espécie de mistura entre drone e míssil, projetada para encontrar radares inimigos, ir atrás deles e destruí-los. É uma arma autônoma de menor risco porque é relativamente improvável que ataque alvos não militares.

Mas há outro, mais preocupante, chamado Kargu-2. Ele é feito por uma empresa turca chamada STM e é mais parecido com esses drones de filmagem. Pesa em torno de 15 kg e aguenta até 1 kg de carga.

Ele nos preocupa porque parece ser projetado para caçar e matar seres humanos. Como é pequeno, não é algo que você usaria para atacar uma base aérea ou um míssil. E tem tecnologia de reconhecimento facial, que endossa esse possível uso contra humanos.

Há relatos da ONU de que o Kargu possivelmente foi utilizado na Líbia em março de 2020. [O relatório não confirma se o equipamento foi usado contra pessoas].

Mas não sabemos muito sobre onde e quando armas autônomas estão sendo usadas. É possível comprar algo e modificar o software para que ele se torne autônomo. É possível que países pequenos estejam fazendo isso sem sabermos.

Tilt: Quais são os países mais avançados no desenvolvimento de armas autônomas?

Laura Nolan: Já mencionei alguns, como Turquia (com Kargu-2) e Israel (com Harpy). Mas é seguro dizer que praticamente todos os países avançados militarmente estão fazendo pelo menos pesquisas na área.

O que chama sua atenção nesse problema?

Laura Nolan: Um dos aspectos que mais me preocupam é a imprevisibilidade dessa tecnologia.

Estes sistemas possuem técnicas de aprendizado de máquina [ou machine learning, em inglês]. Nem todos os robôs a aplicam, mas a maioria usa para tomar decisões, seja reconhecendo indivíduos específicos ou padrões de comportamento para transformar pessoas em alvos.

O aprendizado da máquina é sempre imprevisível devido à natureza da estatística. Ele tende a funcionar bem com os dados com os quais foi treinado, mas o mundo real é muito mais complexo.

O caso dos carros autônomos mostra bem como, mesmo quando você fornece enorme volume de treinamento, dados e experiência para um software, ele tende a se sair mal em qualquer coisa que seja um pouco diferente do que já viu antes.

Máquinas fazem coisas estúpidas porque fazem exatamente o que mandamos elas fazerem. E não podemos prever todas as situações.

Tilt: Principalmente em um cenário de guerra...

Laura Nolan: Estou muito preocupada justamente porque trabalhei minha carreira toda com software. Tive um foco muito grande em automatizar tarefas e vi coisas assim com meus próprios olhos.

Não é que os sistemas estejam necessariamente errados. Muitas vezes você tem uma situação em que eles funcionam, mas não do jeito que se espera.

Nós temos vieses humanos. Somos muito bons em escolher as ações corretas em diferentes cenários e entender o contexto que nos cerca. Somos muito mais flexíveis. E esperamos que as máquinas sejam como nós, mas não são.

Tilt: Há quem defenda que o uso de armas autônomas poderia reduzir o sangue derramado, em um potencial conflito apenas de máquinas contra máquinas. O que você diria a elas?

Laura Nolan: Em uma guerra, não vemos os lados opostos apenas atacando uns aos outros. Pessoas são e sempre serão alvos em guerras. É muito otimismo pensar em dois países fazendo batalhas apenas de robôs, como na TV. Isso não existe.

O que vamos ver serão robôs usados para atacar exércitos humanos ou para atacar áreas onde as pessoas não estão preparadas.

É só ver os drones nos últimos 20 anos. Não tivemos batalhas de drones contra drones, mas sim eles operando em contextos urbanos e atacando pessoas.

É válido pontuar que a Stop Killer Robots reconhece alguns usos para armas autônomas, que nem sempre vão contra os objetivos do Direito Internacional Humanitário. Elas poderiam ser usadas em uma área desabitada, por exemplo. Talvez em alto mar ou no deserto, mas essas situações são muito raras.

E se começarmos a permitir que os robôs tomem suas próprias decisões, é praticamente certo que veremos civis como vítimas em algum momento.

Tilt: Além disso há um problema para testar essas tecnologias em cenários reais, certo?

Laura Nolan: Testar não é a resposta. Há vários cenários em que elas precisariam ser testadas para não cometer erros. Mas há limites de tempo e de dinheiro. Você não conseguiria avaliar em todos os cenários possíveis. É um problema que nunca seria resolvido.

É o que vemos com os carros autônomos. E dirigir é uma atividade muito mais simples do que selecionar um alvo em uma guerra.

Tilt: E o que a campanha Stop Killer Robots já conquistou? Como está a discussão internacional?

Laura Nolan: Não queremos necessariamente banir todas armas autônomas. Coisas como escudos de defesa aérea podem ser usados. Queremos proibir o uso mais perigoso, que ameaça pessoas ou veículos.

Os outros tipos devem ser regulamentados para que sejam menos prejudiciais aos civis. Devemos criar as melhores práticas de uso para garantir que não forneçam riscos.

Houve algum progresso, discussões na ONU, mas obviamente, ainda não conseguimos banir nada.

Isso acontece, em grande parte, porque certas nações poderosas estão bloqueando as tentativas de regulamentação. A Rússia é um destes países; mas outros, como Reino Unido, Estados Unidos e Austrália, não têm colaborado.

O Brasil, inclusive, é um dos países que já se posicionou a favor da regulamentação e banimento de armas autônomas.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.