Por que ChatGPT não distingue se texto foi escrito por humanos ou pela IA?

Seja para consultar se uma informação é verdadeira ou para descobrir se um estudante plagiou um trabalho, o uso de sistemas que prometem detectar se um texto foi gerado por inteligência artificial (IA) tem sido cada vez maior - e polêmico. Exemplos de IAs usadas são GPTZero, ZeroGPT e do próprio ChatGPT.

Porém, tais ferramentas não conseguem identificar com precisão a autoria de um texto, seja ele feito por algoritmos ou humanos, segundo especialistas consultados por Tilt.

O ChatGPT, inclusive, assume suas limitações aos ser questionado se um texto foi escrito por um humano ou uma IA:

Não possuo a capacidade de determinar com precisão se um texto específico foi escrito por uma inteligência artificial ou por um ser humano, a menos que haja informações específicas que possam ser usadas como base para essa análise. ChatGPT

Por que a IA não consegue reconhecer quem escreveu?

Recentemente, histórias de estudantes acusados de trapacear usando IA viralizaram. Em alguns casos, quando professores colocaram os textos produzidos pelos alunos dentro do ChatGPT para análise, ele respondeu que os conteúdos haviam sido gerados com inteligência artificial — o que não se provou verdade posteriormente.

Esse tipo de retorno da tecnologia pode acontecer em diferentes situações. Segundo os entrevistados, isso acontece pois os sistemas de inteligência artificial são criados para parecer convincentes. Ao mesmo tempo, não são capazes de fazer essa distinção.

Quando um texto é criado por humano, mas o algoritmo diz que foi gerado por IA, por exemplo, o erro é classificado como "falso positivo".

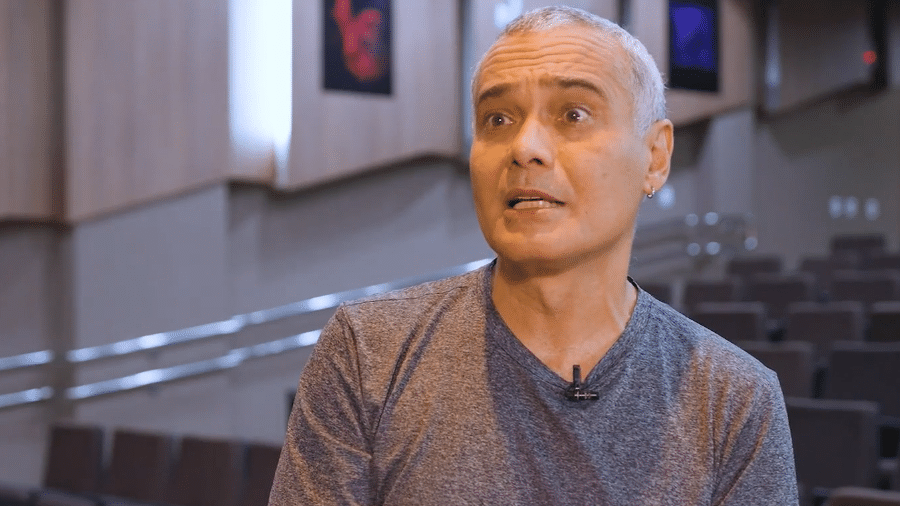

"Para os que trabalham com IA, isso é mais do que o esperado [falso positivo] porque o ChatGPT é o que chamamos de 'gerador de sentenças'. Ele é treinado em uma base de dados do mundo todo e faz ligações entre frases e palavras", explica Anderson Rocha, coordenador do Laboratório de Inteligência Artificial do Instituto de Computação da Unicamp.

"Então quando você pede algo, ele vai gerar as próximas sentenças com base no que você gerou no assunto", acrescenta.

Além disso, destaca o profissional, o chatbot não deve ser usado como um sistema que sabe de tudo. "Quando se faz perguntas, não se deve esperar a resposta 100% correta. Se a pergunta tiver a ver com algo que ele já viu, ele vai reproduzir uma resposta coerente. Mas nem sempre."

Ainda segundo Rocha, se uma pessoa perguntar para o ChatGPT se ele gerou a Constituição Americana, é possível que ele diga que sim.

"Naturalmente no seu treinamento, o ChatGPT viu a Constituição dos Estados Unidos, que é um documento público. Ele vai fazer uma correlação entre as frases daquilo que você está consultando com as frases que viu no treinamento. Como ele acabou vendo esses documentos em diferentes línguas, é possível que diga o que foi gerado por ele, gerando esses falsos positivos", detalha.

Por esse motivo, Rocha defende que o ChatGPT não deve servir como um detector confiável de plágio.

IA dá só um bom palpite

Leonardo Paucar, doutor em engenharia elétrica e professor na área de Ciência da Computação e Inteligência Artificial da Universidade Federal do Maranhão, também concorda que o ChatGPT não é capaz de reconhecer textos produzidos por ele, ou de outros autores.

O motivo também é a própria capacidade que o programa possui de se assemelhar ou até superar a escrita humana por meio do processamento de linguagem natural (NLP).

"O teste de Turing pretende avaliar a capacidade de uma máquina exibir comportamento inteligente. Nesse sentido, um bom sistema baseado em IA passará no teste e não será possível identificar que quem interage é um ser humano ou uma máquina com IA. Cada vez mais os sistemas NLP são mais sofisticados, exibem maior inteligência artificial e, em certas tarefas, podem ser até mais rápidos e melhores que os humanos", explica.

Em última análise, hoje não existe uma maneira de distinguir com 100% de precisão um texto escrito por humanos de outro criado por uma máquina.

Em geral, os detectores de escrita e o ChatGPT podem dar um bom palpite, mas existe uma grande margem de erro, ressalta.

Um estudo de pesquisadores da Universidade de Cornell também demonstrou empiricamente que os detectores de texto gerado por IA não são confiáveis. Na prática, funcionam apenas um pouco melhor do que alguém aleatório.

Para mais vídeos com notícias, dicas e curiosidades de tecnologia e de ciência, siga @tilt_uol no TikTok.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.