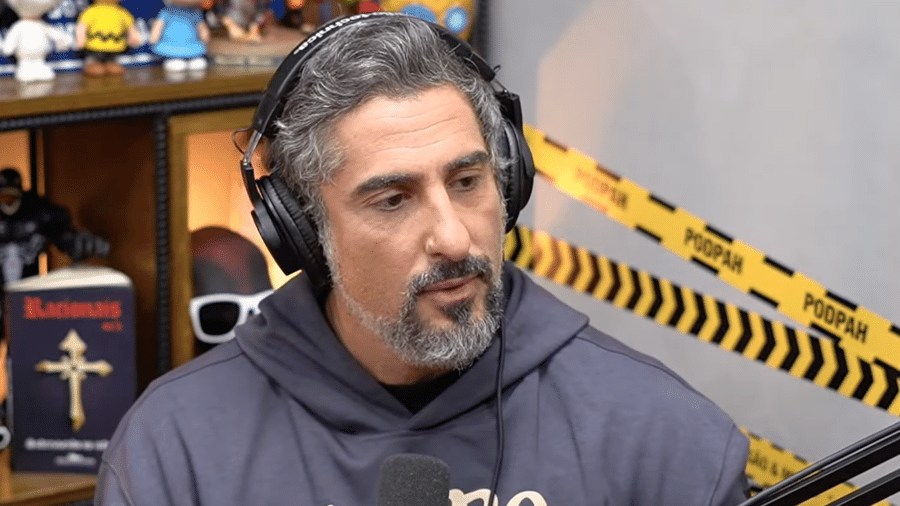

Mion, Drauzio: bandidos usam IA para vender produtos com 'voz' de famosos

Cura para autismo "oferecida" por Marcos Mion e gotas milagrosas para pele '"indicadas" por Drauzio Varella são alguns dos golpes que circulam pela internet usando o nome de famosos. Vídeos são postados em redes sociais e criados com ajuda de IA (inteligência artificial).

O que aconteceu

Reportagem do Fantástico mostrou que golpistas fazem deepfake (arquivos com alteração de voz, imagem ou vídeo com ajuda de IA) com celebridades para tentar vender produtos. No caso de Mion, pegaram um trecho em que ele citava o autismo de seu filho e modificaram para que ele falasse sobre cura da condição — algo que não existe. No caso de Drauzio Varella, usaram um vídeo falso em que ele recomenda "gotinhas milagrosas de colágeno".

Nem sempre as redes sociais removem rapidamente esses vídeos, o que causa prejuízo para os famosos e para as pessoas, que acreditam em vídeos editados, e acabam comprando produtos falsos.

Fala-se na indústria em formas de criar algum tipo de marca d'água ou sinalização de que um conteúdo é deepfake, mas ainda não há nada nesse sentido.

Como geralmente são feitos esses deepfakes

Na internet, há vários serviços — como Voicify e Cover.ai — que permitem treinar uma voz e depois fazer que elas digam um texto em específico. Quanto mais áudios "limpos" da pessoa, mais parecido com o real. Não é difícil achar 10 minutos som de boa qualidade de pessoas famosas que participam em podcasts, por exemplo.

Nos casos de golpe, o que é dito é tirado do contexto e se sobrepõe ao áudio com as imagens em vídeo. Ao reparar bem o vídeo, é possível notar que há falhas de sincronia ou atraso na voz (o som sai antes de a boca se movimentar)

Fazer com que alguém diga um texto com ajuda de inteligência artificial em si não é o problema. A questão é quando se tira do contexto ou se tenta vender algum tipo de produto — o que pode configurar como falsidade ideológica.

O mesmo pode ser feito com o vídeo das pessoas. No entanto, para sair bom, é necessário reunir muitas imagens de um alvo e, em alguns casos, exige ter um computador potente para fazer esse tipo de processamento. Em entrevista de 2019, Bruno Sartori, que ficou famoso por fazer paródias de deepfake com celebridades, disse que pode levar até três dias para treinar um rosto — antes levava quase 30 dias.

Nas eleições de 2022, por exemplo, houve um caso emblemático de deepfake. Um vídeo da apresentadora Renata Vasconcelos estava circulando, dizendo que o candidato à reeleição, Jair Bolsonaro, estava liderando as pesquisas — o que não era verdade.

Dicas para reconhecer um deepfake

- Atenção a movimentos esquisitos e também ao tamanho desproporcional do rosto;

- Vídeos com imagens ruins enganam com mais facilidade;

- Caso o vídeo tenha áudio, atenção a sincronia do som com a boca;

- É mais fácil perceber manipulação em vídeos assistidos em tela cheia e em melhor qualidade;

- Pesquise a procedência da informação passada no vídeo. Se a informação não saiu em veículos confiáveis, certamente é falsa.

Deixe seu comentário

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Leia as Regras de Uso do UOL.