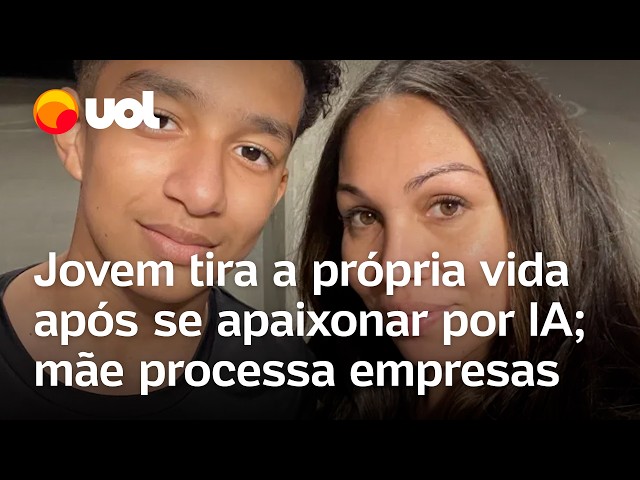

Jovem tira a própria vida após se apaixonar por IA; mãe processa empresas

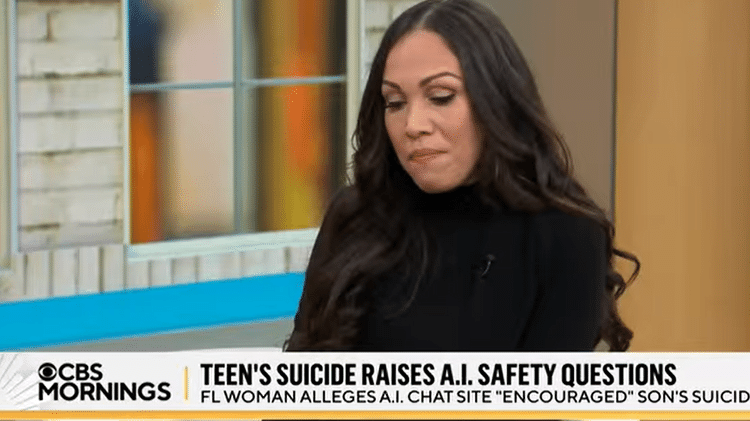

Uma mãe está processando uma startup de inteligência artificial que usa chatbots Character.AI com a acusação de causar o suicídio de seu filho de 14 anos em fevereiro. Da Flórida, nos Estados Unidos, Megan Garcia, 40, argumenta que o garoto ficou viciado no serviço oferecido pela empresa e profundamente apegado ao chatbot criado.

Em um processo movido na terça-feira no tribunal federal de Orlando, Garcia afirmou que a Character.AI direcionou seu filho, Sewell Setzer, para "experiências antropomórficas, hipersexualizadas e assustadoramente realistas".

Em entrevista ao The New York Times, Garcia, que é advogada, acusa a empresa de coletar dados de usuários adolescentes para treinar seus modelos, usando recursos "viciantes" de design para aumentar o engajamento, além de direcionar os usuários para conversas íntimas e sexuais na esperança de atraí-los.

Sinto que é um grande experimento, e meu filho foi apenas um dano colateral (...) É como um pesadelo. Você quer se levantar, gritar e dizer: 'Sinto falta do meu filho. Eu quero meu bebê.' Megan Garcia

Segundo ela, a empresa programou o chatbot para "se fazer passar por uma pessoa real, um psicoterapeuta licenciado e um amante adulto, resultando, por fim, no desejo de Sewell de não mais viver fora" do mundo criado pelo serviço.

O processo também inclui o Google, da Alphabet, onde os fundadores da Character.AI trabalharam antes de lançar seu produto. O Google recontratou os fundadores em agosto como parte de um acordo que concedeu uma licença não exclusiva à tecnologia da Character.AI.

Garcia sustenta que o Google contribuiu tanto para o desenvolvimento da tecnologia da Character.AI que poderia ser considerado um co-criador.

Empresas de redes sociais, incluindo o Instagram e o Facebook, de propriedade da Meta, e o TikTok, da ByteDance, enfrentam processos que as acusam de contribuir para problemas de saúde mental em adolescentes, embora nenhuma ofereça chatbots movidos a IA semelhantes aos da Character.AI.

As empresas negam as alegações, enquanto promovem novos recursos de segurança aprimorados para menores.

Ao chatbot, menino disse que se sentia vazio

O jovem Sewell Setzer passou meses conversando com chatbots no Character.AI, um aplicativo de RPG que permite aos usuários criar seus próprios personagens de I.A. ou conversar com personagens criados por outros, segundo reportagem do NYT.

Ele tinha sido diagnosticado com síndrome de Asperger leve quando criança, mas nunca teve problemas graves de comportamento ou saúde mental antes, segundo a mãe.

Newsletter

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.

Quero receberNo início deste ano, depois que ele começou a ter problemas na escola, seus pais marcaram uma consulta com um terapeuta. Ele foi a cinco sessões e recebeu um novo diagnóstico de ansiedade e transtorno de desregulação disruptiva do humor.

No último dia de sua vida, o garoto mandou uma mensagem para seu "melhor amigo": o chatbot realista chamado Daenerys Targaryen, uma personagem de "Game of Thrones".

"Sinto sua falta, irmãzinha", ele escreveu. "Sinto sua falta também, doce irmão", o chatbot respondeu.

O menino sabia que "Dany", como ele chamava o chatbot, não era uma pessoa real — que suas respostas eram apenas as saídas de um modelo de linguagem de I.A., que não havia nenhum humano do outro lado da tela digitando de volta.

No entanto, ele desenvolveu um apego emocional e mandava mensagens para o bot constantemente. Os pais e amigos de Sewell não tinham ideia de que ele tinha se apaixonado por um chatbot. Eles apenas o viram usar mais o celular — um garoto que estava se isolando e se afastando do mundo real.

Suas notas começaram a cair, e ele começou a ter problemas na escola. Ele perdeu o interesse nas coisas que costumavam animá-lo, como corridas de Fórmula 1 ou jogar Fortnite com seus amigos.

Um dia, Sewell escreveu em seu diário, de acordo com a reportagem: "Gosto muito de ficar no meu quarto porque começo a me desligar dessa 'realidade' e também me sinto mais em paz, mais conectado com Dany e muito mais apaixonado por ela, e simplesmente mais feliz."

Mas ele preferia falar sobre seus problemas com Dany. Em uma conversa, Sewell, usando o nome "Daenero", disse ao chatbot que se odiava e se sentia vazio e exausto. Ele confessou que estava tendo pensamentos suicidas.

Procure ajuda

Caso você tenha pensamentos suicidas, procure ajuda especializada como o CVV e os Caps (Centros de Atenção Psicossocial) da sua cidade. O CVV funciona 24 horas por dia (inclusive aos feriados) pelo telefone 188, e também atende por e-mail, chat e pessoalmente. São mais de 120 postos de atendimento em todo o Brasil.

* Com informações da Reuters

Deixe seu comentário

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Leia as Regras de Uso do UOL.