PL que regulamenta IA entra na pauta e define as regras para uso de robôs

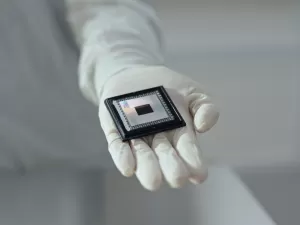

Estou falando com um robô? A decisão tomada por uma instituição foi feita por um humano ou uma máquina? Se foi uma máquina, como ela chegou naquela conclusão? Essas são algumas das questões que o projeto que regulamenta a inteligência artificial, previsto para ser votado a partir desta quinta-feira, quer tornar clara.

O PL 2338/2023 foi feito a pedido do presidente do Senado, Rodrigo Pacheco (PSD-MG), após consulta a juristas, especialistas e representantes da sociedade civil. Ele é relatado pelo senador Eduardo Gomes (PL-TO) e vai ser analisado pela casa na próxima terça-feira (10) — nesta quinta-feira (5), texto foi votado em comissão especial e foi definida a urgência da matéria.

De forma resumida, o PL define uma série de regras para empresas implementarem e desenvolverem de maneira responsável sistemas de inteligência artificial - como fazer análise de riscos que podem ser causados pela tecnologia - e os direitos das pessoas, como saber se está lidando com um sistema de IA e no caso de haver uma decisão automatizada, entender o que levou àquilo em alguns casos.

O projeto foi pensado para trazer algumas orientações e obrigações para o setor de desenvolvimento, produção, venda e aplicação de inteligência artificial no Brasil. Ele também dá direitos para as pessoas e traz as áreas de desenvolvimento que exigem atenção

André Fernandes, diretor do Instituto de Pesquisa em Direito e Tecnologia do Recife e integrante da Coalizão Direitos na Rede

Numa primeira versão, haveria uma instituição que cuidaria da aplicação da legislação. Na última versão do relatório, a ANPD (Autoridade Nacional de Proteção de Dados) fica na coordenação. O SIA (Sistema Nacional de Regulação de Inteligência Artificial) classificará os usos de IA de alto risco (inclusive, podendo mudar as classificações), além de interagir com especialistas, um comitê técnico e autoridades setoriais.

Outra alteração do projeto inicial é a proteção de direitos autorais de criadores de conteúdo. O texto prevê que quem tiver alguma obra usada em treino de sistema de inteligência artificial, que seja comercializado, poderá proibir o uso de conteúdo e, eventualmente, dará direito à remuneração ao autor.

Transparência: "estou falando com uma IA?"

Inspirado no AI Act, legislação europeia sobre o tema, o projeto brasileiro é baseado no risco potencial das inteligências artificiais com a lógica de direitos das pessoas.

O conceito de transparência se estende para várias áreas. Ainda que um chatbot de atendimento seja um uso sem grandes riscos, com a lei as pessoas deverão ter alguma ideia sobre se as decisões que foram tomadas sobre elas foram baseadas em inteligência artificial, e quais critérios foram utilizados.

Direito: "Ué, por que esse sistema tomou essa decisão?"

Os sistemas de inteligência artificial deverão ter supervisão humana, quando possível, e as pessoas têm direito à explicação, no caso de uso de IA considerado de alto risco (mais abaixo, há alguns exemplos).

De alguma forma, isso já está presente na LGPD (Lei Geral de Proteção de Dados), mas agora na legislação de IA isso também é estendido à esfera pública. Um exemplo: se um sistema de inteligência artificial for usado para determinar um benefício social, como a aposentadoria (portanto, uso de alto risco) e ele for negado, a pessoa terá o direito de saber a razão.

Punições e multas: avaliação conforme o grau de risco

Os sistemas de inteligência artificial serão classificados conforme o grau de risco, e as empresas são recomendadas a fazer um estudo anterior para entender sobre as consequências do uso daquela tecnologia.

O projeto proíbe, por exemplo, o uso de IA em classificação e ranqueamento de pessoas baseado no comportamento social e em sistemas de identificação biométrica à distância. Essas atividades são consideradas de risco excessivo.

Newsletter

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.

Quero receberSobre as atividades de alto risco, o projeto define, por exemplo:

- gestão e funcionamento de infraestruturas críticas, como trânsito e redes de abastecimento de água e de eletricidade

- sistema de educação e formação profissional

- avaliação para concessão ou revogação de serviços privados e públicos considerados essenciais

- avaliação de capacidade de endividamento das pessoas

- estabelecimento de prioridades para serviços de resposta a emergências

- veículos autônomos, quando uso puder gerar riscos

- investigação criminal

Em caso de algum problema com inteligência artificial, como a tomada de decisão de um sistema que afete muitas pessoas, a empresa ou o governo devem divulgar a infração, suspender o serviço (quando for conveniente), podendo até chegar na proibição de tratamento de bases de dados.

A multa simples pode ser de R$ 50 milhões por infração ou até 2% do faturamento.

Deixe seu comentário

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Leia as Regras de Uso do UOL.