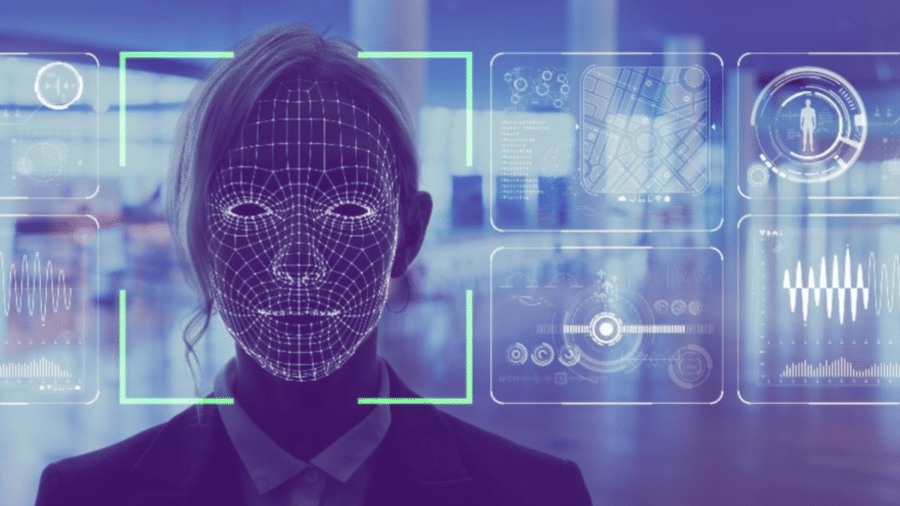

Reconhecimento facial pode detectar orientação política, diz estudo

Michal Kosinski, controverso professor da Universidade Stanford, está de volta. O polonês de 38 anos descreveu em 2013 o uso de curtidas e testes no Facebook para decifrar a personalidade de uma pessoa - a estratégia foi usada posteriormente pela consultoria política Cambridge Analytica (CA) para influenciar a opinião pública em episódios como as eleições americanas de 2016.

Após virar 'profeta' de um dos maiores escândalos do Facebook, Kosinski passou a dedicar seus estudos a potenciais perigos à privacidade causados por tecnologias de reconhecimento facial. Nessa segunda, 11, a prestigiada revista científica Nature publicou o novo artigo do pesquisador, no qual afirma ser possível usar reconhecimento facial para detectar a orientação política das pessoas.

No experimento, o algoritmo analisou mais de 1 milhão de fotos de perfis no Facebook e em sites de namoros em três países: EUA, Canadá e Inglaterra. Ao final, a inteligência artificial (IA) teria identificado corretamente a orientação política dessas pessoas em 72% dos casos - seguindo a classificação amplamente utilizada nos EUA, as pessoas estavam divididas em 'conservadoras' e 'liberais'.

"Provavelmente, o algoritmo está detectando padrões e fazendo combinações que passam despercebidas aos olhos humanos", explica ele ao Estadão. No estudo, a IA determinou 2.048 atributos de descrição da face, embora não seja possível saber o que a máquina captou - é algo que reforça a crítica de que a IA é uma tecnologia pouco transparente.

Críticas

Os resultados e a própria existência da pesquisa devem replicar críticas já feitas anteriormente aos trabalhos de Kosinski. Em 2017, ele publicou na revista The Economist uma pesquisa que afirmava ser possível usar o reconhecimento facial para detectar a orientação sexual das pessoas. Na época, grupos LGBTQ+ dos EUA consideraram o estudo falho e perigoso, enquanto pesquisadores questionaram seu método, linguagem e propósito.

"Eu espero que as pessoas tenham a cabeça mais fria desta vez. A maioria das críticas acontece por não entenderem o que estou fazendo. Eu estou apontando os problemas da tecnologia e os riscos que ela traz para privacidade e direitos civis", diz.

A argumentação para a existência do trabalho e os métodos adotados são problemáticos, dizem especialistas de diferentes áreas.

"Você não precisa explodir uma bomba para saber que ela é perigosa", afirma Sérgio Amadeu, professor da Universidade Federal do ABC (UFABC) e especialista em políticas públicas e inclusão digital. "Me preocupo muito com o tipo de incentivo e sinalização que esse tipo de pesquisa nos traz", diz.

"Isso recicla velhas práticas. É uma atualização do positivismo de Cesare Lombroso", diz ele, em referência ao psiquiatra e criminologista italiano que viveu no século 19 e que dizia ser possível identificar criminosos a partir de suas características físicas. "Agora, porém, a computação é usada para justificar velhos preconceitos."

"É absurdo dizer que é possível extrair uma construção social, como orientação política, a partir de características genéticas e fenotípicas", diz Roberto Hirata Junior, professor da USP. Segundo ele, é possível que exista viés nos dados e nas classificações para indicar orientação política. As informações são do jornal O Estado de S. Paulo.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.