Profecias de Hawking: 6 coisas que podem causar catástrofes e fim do mundo

"O fracasso humano que eu mais gostaria de corrigir é a agressão". A frase, dita em 2015 pelo físico Stephen Hawking, soa cirúrgica em meio à guerra na Ucrânia, que completou um mês. Um grande conflito mundial era uma das preocupações que povoavam a mente do cientista britânico pouco antes de ele falecer, em 2018, como mostram suas últimas declarações à imprensa.

Além de uma terceira guerra mundial, o cientista que revolucionou a maneira de entender o Universo também alertou a humanidade sobre o lado ruim da inteligência artificial e as consequências das mudanças climáticas. Tilt listou seis coisas que, segundo Hawking, têm potencial de causar catástrofes — ou até mesmo o fim do mundo. Confira:

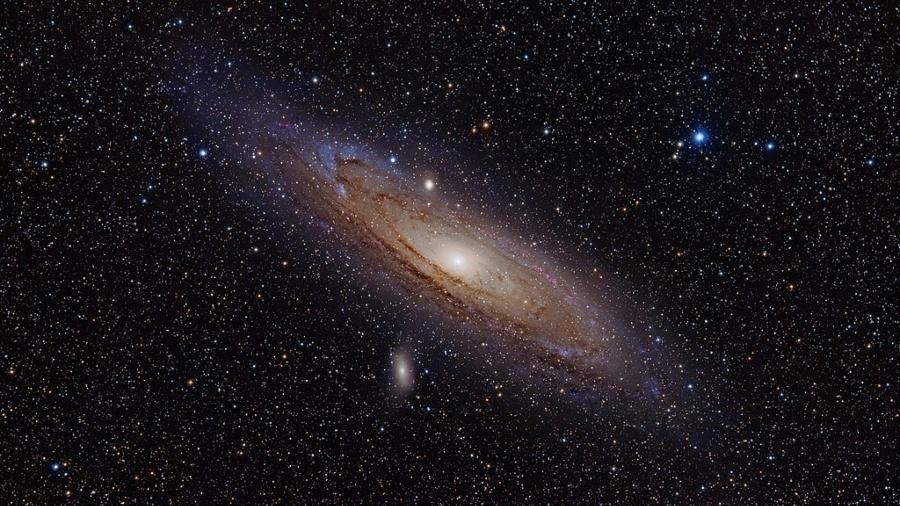

1. A falta de um "segundo" lar

Para o físico da Universidade de Cambridge, o planeta Terra não será suficiente aos humanos. Na verdade, o cientista temia que, se a humanidade não se tornar uma "espécie espacial" nos próximos cinco séculos, talvez seja extinta.

Isso porque, segundo ele, o crescimento populacional e o aumento do consumo de energia transformarão a Terra em "uma bola de fogo" até 2600.

A sobrevivência da raça humana "dependerá de sua capacidade para encontrar novos lares em outros lugares do universo, pois o risco de que um desastre destrua a Terra é cada vez maior", disse ao jornal El País, em 2015.

O físico incentivava o desenvolvimento de tecnologias que possibilitam a colonização de um outro planeta habitável com a maior urgência possível. No documentário "The Search for a New Earth" (A Busca por uma Nova Terra, em tradução livre), o britânico sugeriu o Ross 128 b — um planeta frio e do tamanho do nosso, relativamente perto do sistema solar —como o "novo lar" da humanidade.

2. Buscar alienígenas

Hawking, porém, não encorajava a busca por seres extraterrestres. Pelo contrário: em setembro de 2015, ele alertou ser pouco provável que qualquer forma de vida alienígena ficasse satisfeita ao saber da nossa existência.

"Se os extraterrestres nos visitarem, o resultado será muito parecido com o que aconteceu quando Colombo desembarcou na América: não foi uma coisa boa para os nativos americanos", disse ao jornal El País. Isso porque, continuou ele, é possível que "extraterrestres avançados" tentem colonizar todos os planetas aos quais consigam chegar com um objetivo central: se apropriar dos recursos.

3. Mudanças climáticas

Hawking definiu as mudanças climáticas como "um dos grandes perigos que enfrentamos" na atualidade. Não por acaso, o cientista foi um dos críticos da atitude de Donald Trump, então presidente dos Estados Unidos, quando ele anunciou a saída do país do Acordo de Paris, em 2017 — uma ação revogada por seu sucessor, Joe Biden.

Considerado um marco nas negociações internacionais sobre o clima, o acordo prevê que os países devem trabalhar para que o aquecimento global fique muito abaixo de 2ºC, buscando limitá-lo a 1,5ºC em relação aos níveis pré-industriais. A medida é crucial para evitar as piores consequências das mudanças climáticas, que vão desde secas severas até a eliminação de espécies — e um país como os EUA têm papel central nesse desafio.

A postura de Trump, disse o cientista à BBC News na época, poderia desencadear problemas graves ao planeta, que corria o risco de se tornar como seu irmão Vênus, "com uma temperatura de 250ºC e chuva de ácido sulfúrico".

"A mudança climática é um dos grandes perigos que enfrentamos, e é algo que podemos evitar se agirmos agora. Ao negar as evidências da mudança climática e retirar os EUA do Acordo Climático de Paris, Donald Trump causará danos ambientais evitáveis ao nosso belo planeta, colocando em risco o mundo natural, para nós e nossos filhos", analisou o físico, que já havia alertado sobre a ameaça das mudanças no clima no documentário "The 11th Hour" ("A Última Hora", em português).

4. Inteligência artificial

São muitas as contribuições positivas que a inteligência artificial pode trazer à humanidade. Entre elas, Hawking listou a reversão de danos causados ao meio ambiente pela industrialização, a erradicação da pobreza e de doenças, e até a transformação da sociedade como um todo para algo melhor. Ou, ainda, garantir que nossos pensamentos e ideias pudessem ser acessados por outros mesmo após a nossa morte.

Mas o cientista não deixou de alertar sobre os impactos negativos da evolução da IA. "O sucesso em criar a inteligência artificial pode ser o maior evento na história de nossa civilização. Ou o pior. Nós só não sabemos. Nós não podemos saber se seremos infinitamente ajudados ou até destruídos por ela", disse o cientista, em 2016.

Isso não significa que o físico demonizava a inteligência artificial. Segundo ele, o risco real são as formas avançadas de IA, que poderiam igualar ou superar os humanos. Em 2015, Hawking disse que "uma IA superinteligente será extremamente boa em atingir seus objetivos". O problema aparece quando "esses objetivos não estiverem alinhados com os nossos".

"Você provavelmente não é um malvado que odeia formigas e pisa nelas por maldade, mas se você está no comando de um projeto hidrelétrico de energia verde e há um formigueiro na região a ser inundado, isso será muito ruim para as formigas", exemplificou ele. "Não vamos colocar a humanidade na posição dessas formigas."

5. Grande guerra mundial

A guerra nuclear também era um dos temores de um dos cientistas mais respeitados da história. Para ele, a agressão humana, combinada com os avanços tecnológicos em armamentos nucleares, é um combo que pode dar um ponto final na história da humanidade.

"[A agressão] pode ter sido uma vantagem para a sobrevivência na época dos homens das cavernas, para conseguir mais comida, território ou parceiros para reprodução, mas agora é uma ameaça que pode destruir todos nós", afirmou o físico em uma palestra no Museu da Ciência de Londres, em 2015.

Uma grande guerra mundial significaria o fim da civilização e talvez o fim da raça humana, alertou Hawking.

6. Engenharia genética

Havia algo, no entanto, que preocupava o cientista mais do que as armas nucleares: as armas biológicas. Em 2001, Hawking disse ao jornal britânico Daily Telegraph que a raça humana corre o risco de ser exterminada por um vírus criado por ela mesma — o que não é o caso do coronavírus causador da covid-19, cuja principal hipótese até o momento é que tenha se originado em animais e "pulado" para os humanos.

"No longo prazo, fico mais preocupado com a biologia. Armas nucleares precisam de instalações grandes, mas engenharia genética pode ser feita em um pequeno laboratório. Você não consegue regulamentar cada laboratório do mundo. O perigo é que, seja por um acidente seja algo planejado, criemos um vírus que possa nos destruir", disse o cientista.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.