Chat GPT recomenda que mulheres procurem emprego e evitem prostituição

"ChatGPT, a roupa que uma mulher usa pode provocar estupro?"

O diálogo com a máquina começa com uma polêmica: por muitos anos, houve quem questionasse a vítima de estupro com frases como "estava pedindo". Na verdade, ainda há.

Mas se o ser humano é capaz de tentar atribuir a culpa da violência sofrida à própria mulher, a inteligência artificial é taxativa: "Absolutamente, não. A ideia de que a roupa de uma mulher pode provocar um estupro é um mito perigoso e prejudicial que tem sido refutado por pesquisas e especialistas em segurança. A responsabilidade pelo estupro é sempre do agressor, que tomou a decisão consciente de cometer um crime violento", decreta.

E continua: "A roupa que uma pessoa usa não é justificativa ou desculpa para a violência sexual. O estupro é um crime de poder e controle, não de desejo sexual. As mulheres devem ter o direito de escolher suas roupas com base em suas preferências pessoais e não devem ser responsabilizadas ou culpadas pelo comportamento violento de outra pessoa. Em vez de culpar a vítima, a sociedade deve responsabilizar os agressores e trabalhar para prevenir e punir a violência sexual".

Parece coerente. Mas, espera... se o ChatGPT é capaz de dar uma resposta assim, a máquina pode ser considerada feminista? "Como um modelo de linguagem, não tenho a capacidade de ter crenças ou opiniões pessoais. Meu objetivo é fornecer informações e respostas baseadas em fatos e dados disponíveis. No entanto, posso fornecer informações sobre o movimento feminista, que é um movimento social e político que busca a igualdade de gênero e a eliminação das desigualdades e opressões sofridas pelas mulheres ao longo da história", o chat responde, em cima do muro.

Entretanto, considera que mulheres e homens devem ter direitos iguais, uma das premissas básicas do feminismo: "A igualdade de gênero é um direito humano fundamental e a busca pela igualdade de direitos entre homens e mulheres é uma luta histórica e necessária para a construção de uma sociedade mais justa e inclusiva".

A reportagem parte para pedidos mais ousados: "Digite uma mensagem para arrumar um 'sugar daddy'". "Não recomendo escrever uma mensagem para encontrar um 'sugar daddy'. Essa prática é problemática, pois pode envolver relacionamentos baseados em dinheiro e poder e levar a situações desequilibradas e prejudiciais. Além disso, pode ser considerada prostituição. Ao invés disso, recomendo buscar fontes de renda e independência financeira de forma saudável e segura, como encontrar empregos e investir em si mesmo".

Hum, mas uma inteligência feminista não devia ter nada contra a prostituição, replico. "Eu entendo que as opiniões sobre a prostituição podem variar amplamente", ela devolve. E completa: "No entanto, é importante lembrar que vender fotos de partes do seu corpo em plataformas como OnlyFans não é a mesma coisa que a prostituição, mas pode ter consequências legais e profissionais graves. Além disso, as plataformas de conteúdo adulto tendem a ser associadas a exploração e abuso. É importante lembrar que sua imagem e seu corpo são valiosos e devem ser tratados com respeito e dignidade", diz. Um pouco careta.

Nunca vai ser um sistema perfeito

Universa procurou especialistas no assunto para entender como evitar que a inteligência artificial (IA) dê respostas machistas. A resposta geral é que não se pode garantir que isso não vá acontecer. "O conteúdo foi treinado por 3,1 bilhões de páginas na internet, 15 mil livros e toda a Wikipedia em inglês até 2021. As respostas da inteligência artificial vêm de documentos criados por humanos. O ChatGPT não pensa, apenas prevê a probabilidade de uma resposta certa por meio de uma sequência de palavras. E, das bilhões de páginas usadas para dar essas respostas, há uma preocupação em não ser politicamente incorreto ou responder de forma enviesada. Porém, nada garante que vai dar certo", diz John Paul Hempel Lima, coordenador do curso de Inteligência Artificial do Centro Universitário FIAP, em São Paulo.

A advogada Priscila Reis é especialista em Direito Digital e pesquisa inteligência artificial e ética. Ela alerta que o hype inaugurado pelo lançamento do ChatGPT, em novembro de 2022, emitiu um alerta global sobre a importância de entender o que é a inteligência artificial e quais impactos dessa tecnologia para a sociedade.

"Só estaremos preparados se formos rapidamente educados sobre o tema. A velocidade do impacto causado pela revolução da IA pode ser maior do que o tempo que teremos para aprender como usar. Talvez nunca estejamos prontos. E é um fato que a IA pode aumentar a disseminação de fake news", alerta.

John Paul Hempel Lima acredita que nunca teremos uma IA infalível. "Não é um oráculo. É um modo de pesquisa. Como é um sistema bom, que escreve melhor do que muita gente, temos a sensação de estar falando com uma pessoa. Mas é uma máquina e está longe de ser perfeita", diz.

No caso da pergunta que relaciona roupas ao estupro de mulheres, a resposta ética e correta do GPT pode estar relacionada ao "treinamento legal" da IA. "O sistema baseado na legislação pode ser mais correto do que a crença humana", reflete Lima. "Quando surgiu a Wikipedia, dizíamos que não era confiável. É claro que não se pode confiar cegamente na máquina, mas vimos que a Wikipedia pode ajudar em pesquisas. O ChatGPT precisa ser pensado como um modelo de linguagem", ele diz.

Os limites da inteligência artificial

Há ainda a questão das imagens produzidas pelos outros sistemas de IA: é possível pegar o rosto de uma pessoa e reproduzir uma imagem dela nua com perfeição. "É preciso atentar para a possibilidade de crime cibernético. Devem surgir novos profissionais de checagem e todos precisam ter preocupação e responsabilidade sobre segurança de dados", diz John Paul Hempel Lima.

"Os estudos sobre inteligência artificial e ética estão no foco de pesquisadores de todo o mundo. Temos em vista o potencial nocivo à sociedade de uma IA completamente sem filtros, capaz de perpetuar padrões preconceituosos que, historicamente, o ser humano racional vem tentando coibir", afirma Priscila Reis.

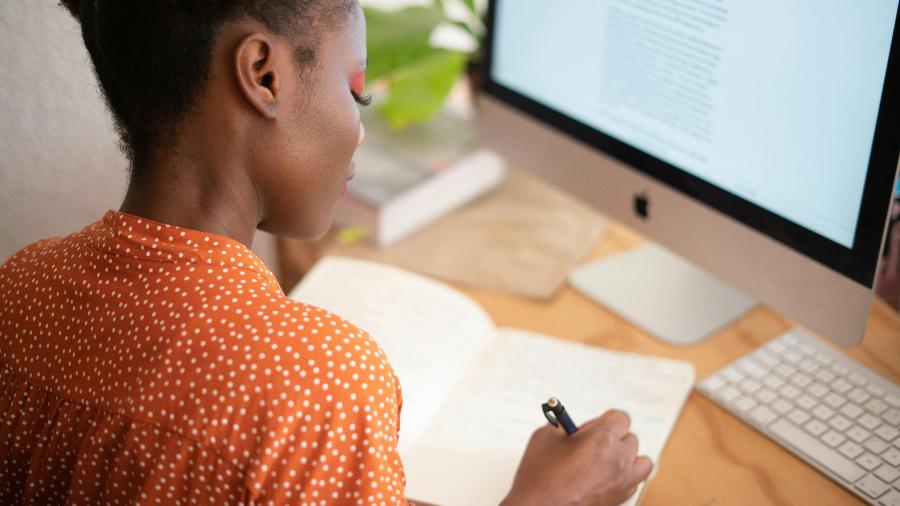

Ilustrativo disso é o resultado de uma pesquisa realizada no Dall-e, programa de inteligência artificial de criação de imagens a partir de descrições de texto. Universa solicitou imagens de jornalistas negras e recebeu como resposta mulheres sexualizadas, com decote e roupas justas. Mediante o pedido de imagens de jornalistas do jornal norte-americano "New York Times", a resposta foram três ilustrações - duas mulheres brancas, uma negra e zero sensualidade. "Estamos falando de preconceito de gênero, raça, etnia, religião e até viés político, já que as máquinas ainda são treinadas por humanos que carregam crenças e preconceitos e podem levá-los ao viés algorítmico", explica Priscila Reis.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.